La visibilité en ligne devient de plus en plus instable. La faute à des positions Google volatiles, des recommandations IA imprévisibles, une baisse des recherches “classiques” et de nouvelles règles de fonctionnenement qui brouillent les repères classiques du SEO. Une entreprise peut perdre du trafic ou des opportunités locales sans chute visible dans Google. Les IA citent des marques de façon incohérente, filtrent plus sévèrement, et utilisent parfois des sources peu fiables, rendant la mesure et la décision plus risquées.

Cette revue du web aide à comprendre ce qui se passe réellement derrière ces signaux : algorithmes, IA, régulation, publicité et données utilisateurs. L’objectif : reprendre le contrôle sur vos décisions SEO et contenu en 2026.

Cette semaine dans la revue du web, je vous parle de :

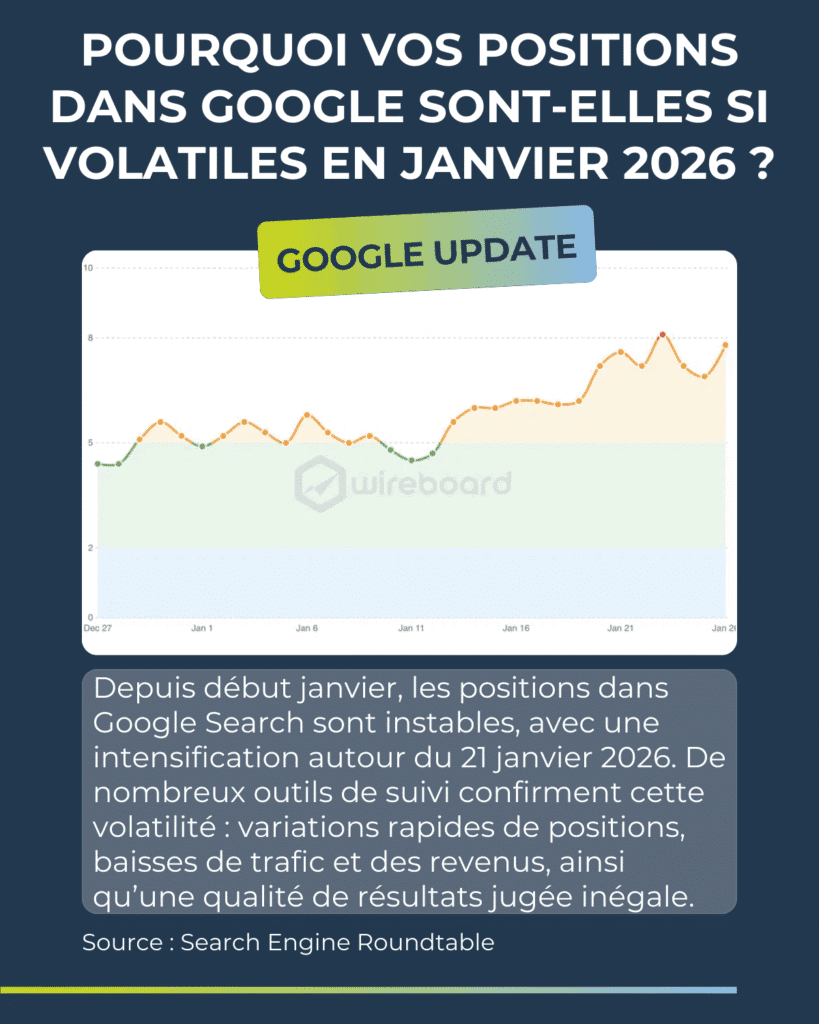

- Volatilité Google : fortes fluctuations de positions en janvier 2026, rendant le pilotage SEO plus incertain.

- Intention de recherche : Google semble élargir certaines requêtes, générant un trafic moins qualifié.

- Recherche locale et IA : être recommandé par les IA est jusqu’à 30 fois plus difficile que d’apparaître dans le local pack Google.

- Instabilité des recommandations IA : les listes de marques citées changent presque à chaque réponse.

- Baisse des recherches Google : près de –20 % de recherches par utilisateur aux États-Unis en 2025.

- Contrôle des contenus IA : Google envisage de permettre aux sites de refuser l’usage de leurs contenus dans AI Overviews et AI Mode.

- Régulation européenne : le DMA pourrait forcer Google à partager certaines données de recherche et d’IA.

- Données utilisateurs : Google confirme leur rôle central dans l’évaluation de la qualité et du classement.

- Publicité sur ChatGPT : arrivée de formats au CPM élevé, avec peu de données de mesure au départ.

- Monétisation anticipée de ChatGPT : l’algorithme a évolué avant même l’annonce officielle des publicités.

- Compréhension de l’intention avant la requête : Google analyse les comportements pour deviner l’objectif de l’utilisateur.

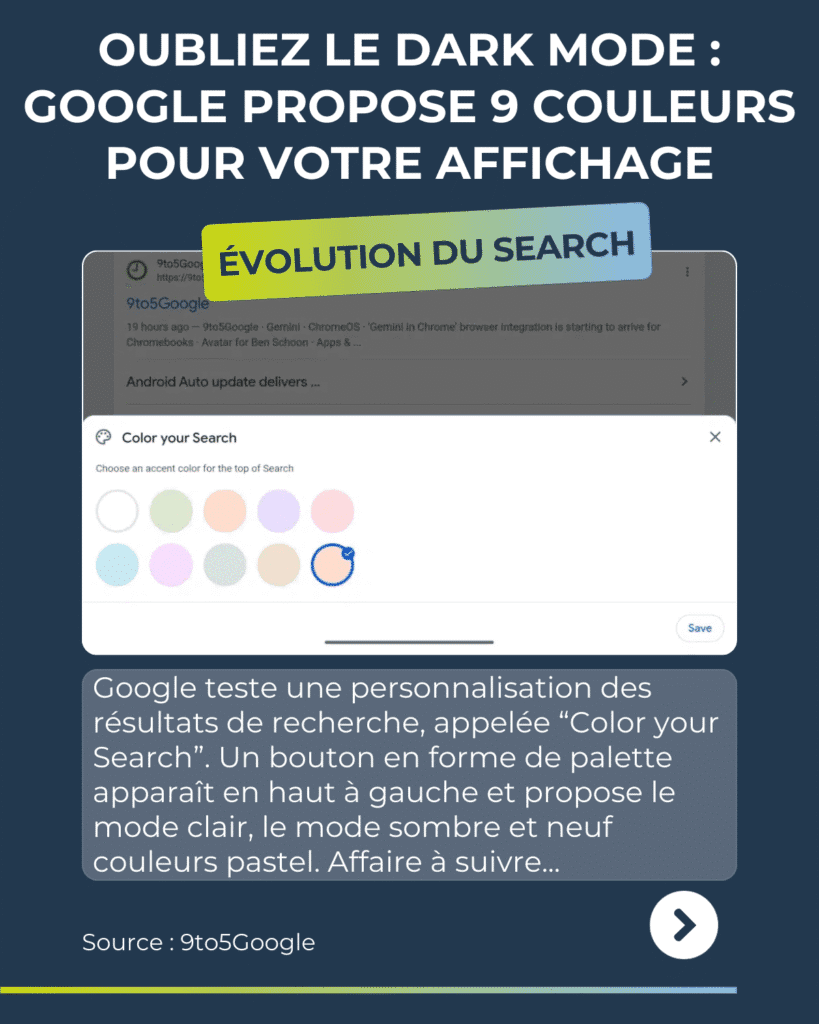

- Personnalisation de l’interface Search : Google teste des options visuelles sans impact SEO direct.

- Nouveaux crawlers Google : apparition de GoogleMessages pour les aperçus de liens partagés.

- Sécurité WordPress : plusieurs plugins vulnérables exposent encore des milliers de sites.

- Qualité des IA : OpenAI reconnaît une baisse de qualité rédactionnelle sur GPT-5.2.

- ROI de l’IA : 56 % des entreprises n’observent toujours aucun bénéfice concret après un an.

- Fiabilité des sources IA : ChatGPT cite parfois des encyclopédies générées par IA, sans validation humaine.

- Segmentation par âge : ChatGPT adapte désormais ses réponses selon l’âge estimé des utilisateurs.

Bonne lecture !

Table des matières

Pourquoi vos positions dans Google sont-elles si volatiles en janvier 2026 ?

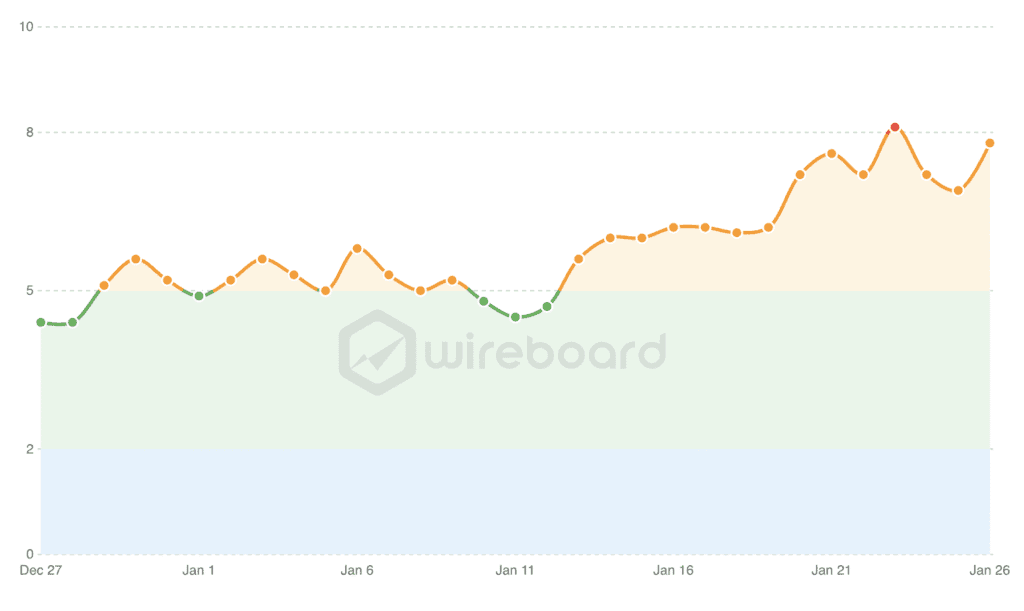

Depuis début janvier, les positions dans Google Search connaissent une forte instabilité, avec une intensification autour du 21 janvier 2026. De nombreux outils de suivi confirment cette volatilité. Sur le terrain, les professionnels du SEO observent des variations rapides de positions, des baisses de trafic et des revenus, ainsi qu’une qualité de résultats jugée inégale.

Pourquoi c’est important ?

Cette instabilité rend les stratégies digitales difficiles à piloter. Une baisse soudaine de trafic peut affecter la génération de leads ou les revenus publicitaires sans action interne identifiable pour corriger. Un risque pour les entreprises et les équipes marketing est de prendre de mauvaises décisions, comme réduire les investissements, alors que le problème vient d’un contexte algorithmique temporaire.

Conséquences sur le SEO et la stratégie de contenu

Dans ce contexte, il devient essentiel de suivre les tendances sur plusieurs semaines, et non au jour le jour. Il faut renforcer la qualité éditoriale, la cohérence entre les requêtes et les contenus, et diversifier les canaux d’acquisition. Le SEO doit rester un pilier, mais sans dépendance exclusive aux fluctuations de Google.

Mon conseil SEO : toujours comparer des plages de plusieurs semaines ou plusieurs mois pour réellement constater l’effet d’une action marketing.

Google aurait un problème d’intention de recherche mal comprise

Plusieurs retours indiquent que Google semble élargir l’interprétation des requêtes des internautes. Cela entraîne l’arrivée d’un trafic moins qualifié, car la page affichée ne correspond plus exactement au besoin initial. Cela peut réduire les conversions, même si le volume de visites reste stable.

Pourquoi Discover et Google News sont-ils soue le feu des critiques en janvier 2026 ?

Certains professionnels signalent une montée de contenus jugés faibles dans Discover et Google News, comme des articles très basiques ou des traductions de faible qualité. Cette perception alimente un sentiment d’incohérence dans les choix de Google, avec des hausses et baisses soudaines qui donnent une impression de manque de stabilité globale.

- Google Search Ranking Volatility Remains Super Heated Source : Search Engine Roundtable

- Classements Google : nouvelle séquence de fortes secousses fin janvier Source : Position Zéro

Rapport : être visible dans l’IA locale est 30x plus difficile que sur Google

Le rapport de SOCi (2026) montre que les assistants IA recommandent très peu d’adresses locales. Sur près de 350 000 établissements, ChatGPT n’en recommande que 1,2%, Gemini 11% et Perplexity 7,4%. À titre de comparaison, les marques apparaissent dans le “local 3-pack” de Google 35,9% du temps.

Pourquoi c’est important ?

Si une entreprise dépend des recherches locales pour générer des demandes, être bien classé sur Google ne suffit plus. L’IA filtre plus fort et peut ignorer des établissements pourtant visibles. Cela crée un nouveau risque business : perdre des opportunités sans baisse évidente de positions dans Google.

Conséquences sur le SEO et la stratégie de contenu

A vous de sécuriser les informations de votre entreprise partout où l’IA peut les lire : site, annuaires professionnels, plateformes d’avis et pages de profils. Les avis deviennent un filtre majeur : l’IA recommande surtout les mieux notés. Côté contenu, renforcer les pages locales, les preuves de crédibilité et la cohérence des données devient prioritaire.

Pourquoi l’IA recommande-t-elle si peu d’établissements ?

Selon le rapport de SOCI, l’IA est plus “sélective” que Google. Google peut afficher beaucoup d’options selon la proximité et la catégorie. L’IA, elle, cherche à réduire le risque de déplaire à l’internaute et préfère ne recommander que quelques choix triés sur le volet. Résultat : une entreprise peut avoir de bons résultats sur Google, mais être totalement absente des recommandations IA.

Quel est le rôle exact des avis clients dans les citations IA ?

Dans ce rapport, les avis client serviraient de filtre pour les LLM. Les établissements recommandés ont de meilleures notes moyennes : 4,3 étoiles pour ceux cités par ChatGPT, 3,9 pour Gemini et 4,1 pour Perplexity. Contrairement à Google, où une note moyenne peut encore suffire, l’IA exclut plus souvent les profils perçus comme “moyens.”

Sur Google, on peut gagner en visibilité en travaillant la pertinence et la proximité. Ici, le rapport suggère un changement : l’IA sélectionne d’abord les établissements avant de les recommander. Elle favorise des signaux jugés fiables : données exactes, profils complets, avis positifs. Sans ces bases, certaines marques deviennent invisibles.

- AI local visibility is up to 30x harder than ranking in Google: Report Source : Search Engine Land

- The 2026 Local Visibility Index Source : Soci

Les marques citées par l’IA changent presque à chaque fois

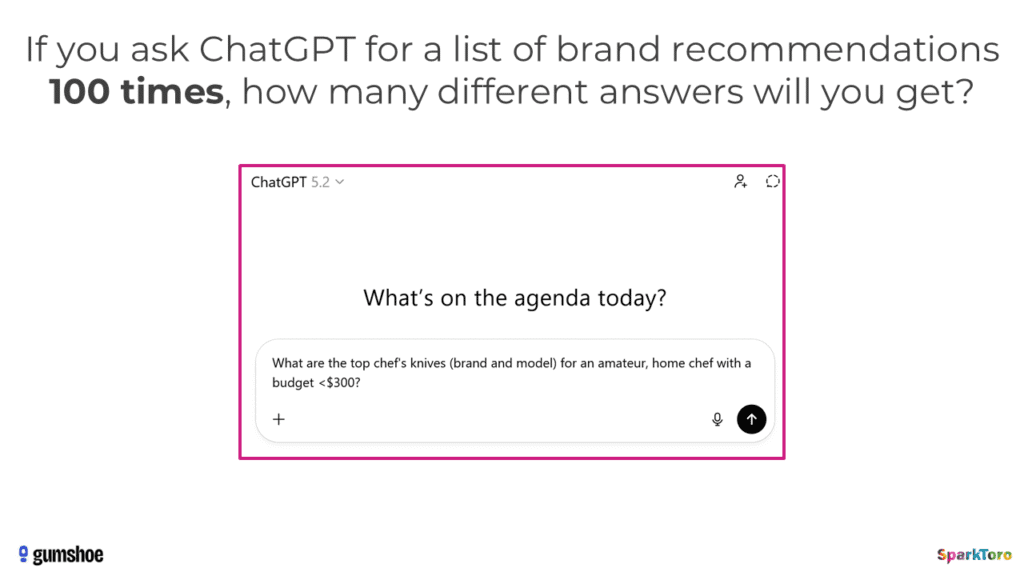

Une étude menée par Rand Fishkin et Patrick O’Donnell a testé la stabilité des recommandations de ChatGPT, Claude et de l’IA de Google. Six cents volontaires ont lancé 12 prompts identiques près de 3 000 fois. Résultat : obtenir deux fois la même liste arrive dans moins de 1% des cas, et le même ordre encore plus rarement.

Conséquences sur le SEO et la stratégie de contenu

Le suivi “de position” dans les réponses IA n’est pas fiable, car l’ordre des marques citées et la longueur des listes bougent beaucoup. Un indicateur plus solide semble être la fréquence d’apparition de la marque dans de nombreux prompts testés sur les LLM (“pourcentage de visibilité”). Côté contenu, l’enjeu est d’être cité souvent sur un même besoin, pas d’être premier une fois.

Pourquoi les réponses des IA varient-elles autant, même avec le même prompt ?

Les LLM sont basés sur des probabilités : ils produisent volontairement des réponses différentes. Ils ne cherchent pas à afficher une liste fixe comme les liens bleus de Google. La variation porte sur les noms cités, l’ordre des choix et même le nombre de recommandations proposées dans la liste.

Pourquoi le marché et le type de besoin changent la fréquence d’apparition dans les réponses IA ?

Plus le choix est vaste, plus la liste part dans tous les sens. Dans un petit marché (acteurs peu nombreux), les réponses se regroupent autour de quelques noms connus. Dans une grande catégorie (beaucoup d’options possibles), les recommandations se dispersent fortement. L’étude observe aussi que, même avec des formulations très différentes, l’intention reste bien captée.

- AI recommendation lists repeat less than 1% of the time: Study Source : Search Engine Land

- NEW Research: AIs are highly inconsistent when recommending brands or products; marketers should take care when tracking AI visibility Source : Sparktoro

En 2025, les internautes américains ont effectué près de 20% de recherches Google en moins

Un rapport Datos/SparkToro montre qu’en 2025, les utilisateurs américains ont effectué près de 20% de recherches Google en moins par personne sur ordinateur. Google ne perd pas d’utilisateurs, mais des recherches répétées. En Europe, la baisse reste limitée à 2–3%, ce qui souligne un changement de comportement surtout visible aux États-Unis.

Pourquoi c’est important ?

Moins de recherches par utilisateur signifie moins d’occasions d’être découvert. Même si Google reste dominant, chaque requête compte davantage. Pour une PME B2B, cela implique une concurrence plus forte sur un volume d’opportunités réduit, avec un risque accru de voir le trafic et les leads stagner sans adaptation stratégique.

Conséquences sur le SEO et la stratégie de contenu

Votre contenu doit répondre plus vite et plus précisément aux besoins de vos prospects, car les utilisateurs font moins de recherches successives. Les requêtes deviennent plus longues et plus détaillées. Il devient prioritaire de cibler des intentions claires, de structurer les pages pour des réponses directes, et de mesurer la performance sur moins de clics mais plus qualifiés.

Quel rôle joue l’IA dans la baisse des recherches en ligne ?

Le rapport suggère que les réponses instantanées et enrichies par l’IA réduisent les recherches de suivi. Les utilisateurs obtiennent plus souvent une réponse complète dès la première requête. Les recherches “sans clic” restent élevées mais se stabilisent, signe que ce nouveau comportement est désormais installé.

Pourquoi la phase de découverte d’une marque devient-elle plus difficile ?

Les destinations après recherche changent peu et restent concentrées sur quelques grandes plateformes comme YouTube, Amazon ou Wikipedia. Les outils d’IA redirigent eux aussi surtout vers ces acteurs établis. Pour les petits acteurs d’un marché ou les nouveaux arrivants, entrer dans ce cercle devient plus complexe, car la visibilité se concentre sur moins de sites.

- State of Search Q4 2025: Behaviors, Trends, and Clicks Across the US & Europe Source : Datos

- Google searches per U.S. user fell nearly 20% YoY: Report Source : Search Engine Land

Vous en avez assez des features IA sur Google ?

Google étudie la possibilité de permettre aux sites de refuser l’utilisation de leurs contenus dans les fonctionnalités d’IA de Search, comme AI Overviews et AI Mode. Cette réflexion fait suite aux exigences du régulateur britannique CMA, tout en cherchant à préserver une expérience de recherche cohérente pour les utilisateurs.

Pourquoi c’est important ?

Les contenus produits par les marques peuvent aujourd’hui alimenter des réponses IA sans générer de clic ni de visibilité directe. La possibilité de refuser cet usage permet de mieux arbitrer entre notoriété, trafic et protection de ses contenus stratégiques, en particulier sur des sujets à forte valeur commerciale.

Conséquences sur le SEO et la stratégie de contenu

Si ces options voient le jour, il faudra décider quels contenus laisser accessibles aux IA et lesquels protéger. Les pages à fort potentiel de conversion pourraient être traitées différemment des contenus informatifs. La mesure de performance devra aussi intégrer l’impact des réponses IA, même en l’absence de clics.

Pourquoi Google avance avec prudence sur l’accès accordé à ses IA ?

Google explique que ces nouveaux contrôles risquent de “casser” le fonctionnement de Search. L’enjeu est d’éviter une recherche fragmentée ou confuse pour les utilisateurs. Les solutions devront donc être simples, compatibles avec les standards existants et applicables à grande échelle pour les sites.

Supprimer l’accès aux robots d’entrainement de Google : est-ce vraiment une nouveauté pour les éditeurs de site ?

Pas vraiment. Google rappelle qu’il existe déjà des outils de contrôle, comme robots.txt ou Google-Extended, pour gérer l’affichage et l’entraînement de ses modèles IA. La nouveauté serait de permettre un refus plus ciblé des fonctionnalités d’IA générative dans Google Search.

- Google may give sites a way to opt out of AI search generative features Source : Search Engine Land

- Google Exploring Ways To Allow Sites To Opt Out Of AI Overviews & AI Mode Source : Search Engine Roundtable

- Google May Let Sites Opt Out Of AI Search Features Source : Search Engine Journal

Ce que les déboires judiciaires de Google nous apprennent sur le SEO en 2026

La Commission européenne ouvre de nouvelles procédures contre Google dans le cadre du Digital Markets Act. Elle veut préciser comment Google doit partager certaines données de recherche et fonctionnalités IA d’Android avec ses concurrents. L’objectif est d’encadrer plus strictement l’usage des données et des technologies IA dominantes.

Pourquoi c’est important ?

Ces décisions peuvent modifier l’équilibre du marché numérique. Une ouverture des données de recherche ou des fonctionnalités IA pourrait favoriser de nouveaux acteurs et réduire la dépendance à Google. À moyen terme, cela peut influencer les canaux d’acquisition, les coûts publicitaires et la visibilité des PME sur différents écosystèmes.

Si l’accès aux données de recherche se diversifie, la visibilité ne dépendra plus uniquement de Google. Les PME devront suivre leurs performances sur plusieurs moteurs et assistants IA. La mesure du trafic, de l’attribution et de la performance SEO pourrait devenir plus fragmentée et nécessiter de nouveaux indicateurs.

Que signifie le partage des données de recherche ?

La Commission souhaite que Google partage des données anonymisées sur les requêtes, les clics et les classements. Ces données aideraient d’autres moteurs à s’améliorer. Le débat porte sur le périmètre exact, les conditions d’accès et le risque de donner un avantage trop fort aux concurrents directs.

- EU puts Google’s AI and search data under DMA spotlight Source : Search Engine Land

Pourquoi les données utilisateurs sont centrales dans Google Search ?

Des documents du procès entre le DOJ et Google montrent l’importance stratégique des données utilisateurs dans le fonctionnement de Google Search. Ces données servent à évaluer la qualité, la fraîcheur et le spam des pages, et à entraîner des modèles d’IA comme RankEmbed BERT, essentiels au classement des résultats.

La visibilité sur Google ne dépend pas seulement du contenu publié, mais aussi de la manière dont les utilisateurs interagissent avec celui-ci. Comprendre que Google valorise la satisfaction réelle des internautes aide les dirigeants à prioriser des contenus utiles, clairs et engageants plutôt que des optimisations purement techniques.

Qu’est-ce que le système “Glue” mentionné par Google ?

Glue est une base interne qui enregistre les requêtes, le contexte de recherche et les actions des utilisateurs sur les résultats. Elle permet à Google de comprendre ce qui satisfait réellement les internautes. Ces données servent ensuite à entraîner et ajuster les systèmes de classement.

Que retenir pour une stratégie de contenu B2B ?

Le message principal est clair : Google cherche à satisfaire les utilisateurs avant tout. Les contenus qui répondent réellement aux besoins, restent pertinents dans le temps et évitent les pratiques trompeuses ont plus de chances d’être valorisés, car ils génèrent de bons signaux d’engagement.

- User Data Is Important In Google Search, Per Liz Reid’s DOJ Filing Source : Search Engine Journal

- Google outlines risks of exposing its search index, rankings, and live results Source : Search Engine Land

- Affidavit of Elizabeth Reid Source : Court Listener – USAl

Publicités dans ChatGPT en février 2026 : un CPM élevé et des possibilités limitées

OpenAI va tester des publicités dans ChatGPT dès février 2026. Elles s’afficheront en bas des réponses, séparées et marquées « sponsorisées ». Le modèle annoncé repose surtout sur le CPM, et pas sur le clic. Les premiers tests visent peu d’annonceurs, avec des engagements financiers très élevés et peu d’outils en libre-service.

Pourquoi c’est important ?

Ce lancement annonce un nouveau canal d’influence (mais surtout pour les entreprises qui peuvent se le permettre). Des décisions d’achat pourront se jouer dans une conversation, sans passer par Google. Cela change les arbitrages budgétaires à venir, mais aussi la concurrence : visibilité “premium”, coût élevé, et risque de payer sans preuve claire de performance.

Conséquences sur le SEO et la stratégie de contenu

Le SEO ne suffit plus à capter la demande : ChatGPT peut orienter l’attention avec une zone sponsorisée. Il devient utile de renforcer les contenus qui rassurent et différencient (pages offres, preuves, FAQ, comparatifs, cas clients). Côté mesure, prévoir des signaux indirects (recherches de marque, demandes entrantes) plutôt qu’un suivi au clic.

Qu’est-ce que le CPM ?

Le CPM signifie “coût pour mille impressions”. Une impression, c’est un affichage de l’annonce, même sans clic. Pour OpenAI, cela sécurise le revenu. Pour l’annonceur, c’est plus risqué, car la rentabilité dépend d’effets difficiles à relier directement à l’annonce, surtout avec peu de données.

Pourquoi les résultats publicitaires sur ChatGPT seront difficiles à mesurer au début ?

Les articles sur le sujet indiquent que le reporting sera limité : nombre d’impressions et parfois clics, sans suivi des actions après. OpenAI insiste aussi sur la confidentialité des conversations et sur l’absence de vente de données. Résultat : moins de ciblage, moins d’attribution, et des tests plutôt orientés notoriété que performance.

- OpenAI Seeks Premium Prices in Early Ads Push Source : The Information (article de blog accessible uniquement aux abonnés payants)

- ChatGPT ads come with premium prices — and limited data Source : Search Engine Land

- OpenAI To Charge Based On Ad View Impressions, Not Clicks Source : Search Engine Roundtable

- Des publicités sur ChatGPT, oui mais au CPM ? Ce qu’il faut savoir Source : LEPTIDIGITAL

OpenAI envisageait déjà de se monétiser dès fin 2025

Selon une étude de Seer Interactive, ChatGPT a modifié son algorithme dès le 1er décembre 2025, soit 46 jours avant d’annoncer officiellement l’arrivée de la publicité le 16 janvier 2026. Cette conclusion repose sur l’analyse de 206 412 réponses de ChatGPT couvrant 43 marques.

Les données révèlent une préparation progressive à la monétisation :

- forte hausse du nombre de citations par réponse,

- priorité donnée aux requêtes à intention commerciale,

- baisse de la visibilité organique pour plus de la moitié des marques,

- changements dans les sources citées, au profit de plateformes déjà monétisées.

Autrement dit, ChatGPT avait déjà préparé le terrain bien avant 2026, sans communication publique. Difficile, donc, d’avpir une mesure claire de la visibilité d’une marque sur les moteurs IA, quand illes peuvent décider de changer leur algorithme comme bon leur semble.

- ChatGPT Changed Their Algorithm 46 Days Before Announcing Ads Source : Seer Interactive

Cette recherche Google va-t-elle mettre fin aux mots-clés dans le SEO ?

Google travaille sur une façon de comprendre l’intention de recherche avant qu’une requête ne soit tapée. Grâce à de petits modèles d’IA intégrés directement sur les appareils, Google analyse les actions à l’écran (clics, défilement, navigation) pour déduire l’objectif global d’un utilisateur, plus vite, à moindre coût et sans envoyer les données dans le cloud.

Pourquoi c’est important ?

Cette évolution annonce un changement profond dans la manière dont les prospects découvrent des solutions sur interne. La visibilité d’une marque ne dépendra plus uniquement des mots-clés saisis, mais aussi de la cohérence des parcours utilisateurs. Les entreprises devront penser en termes d’expérience globale, pas seulement présence dans les résultats de recherche classiques.

Conséquences sur le SEO et la stratégie de contenu

Les contenus de votre entreprise devront accompagner des parcours logiques et compréhensibles : pages bien structurées, intentions claires, continuité entre contenus. Les mots-clés restent utiles, mais deviennent un signal parmi d’autres, au même titre que la navigation, l’ordre des pages et les actions réalisées.

Comment Google peut-il deviner l’intention de recherche sans requête tapée par les utilisateurs ?

Google découpe l’analyse en deux étapes simples. D’abord, chaque interaction à l’écran est résumée séparément. Ensuite, un second modèle synthétise ces résumés pour formuler l’objectif global de l’utilisateur. Cette méthode évite les erreurs fréquentes des petits modèles et réduit les interprétations hasardeuses.

Les mots-clés vont-ils disparaître de la stratégie SEO ?

Non. Les mots-clés resteront importants, mais ils ne suffiront plus. La requête devient la dernière étape visible d’un raisonnement plus large. Google cherchera à comprendre ce que l’utilisateur fait avant, pendant et après la recherche pour proposer des réponses plus pertinentes et plus contextualisées.

- Small models, big results: Achieving superior intent extraction through decomposition Source : Google Research

- Google research points to a post-query future for search intent Source : Search Engine Land

- Google’s New User Intent Extraction Method Source : Search Engine Journal

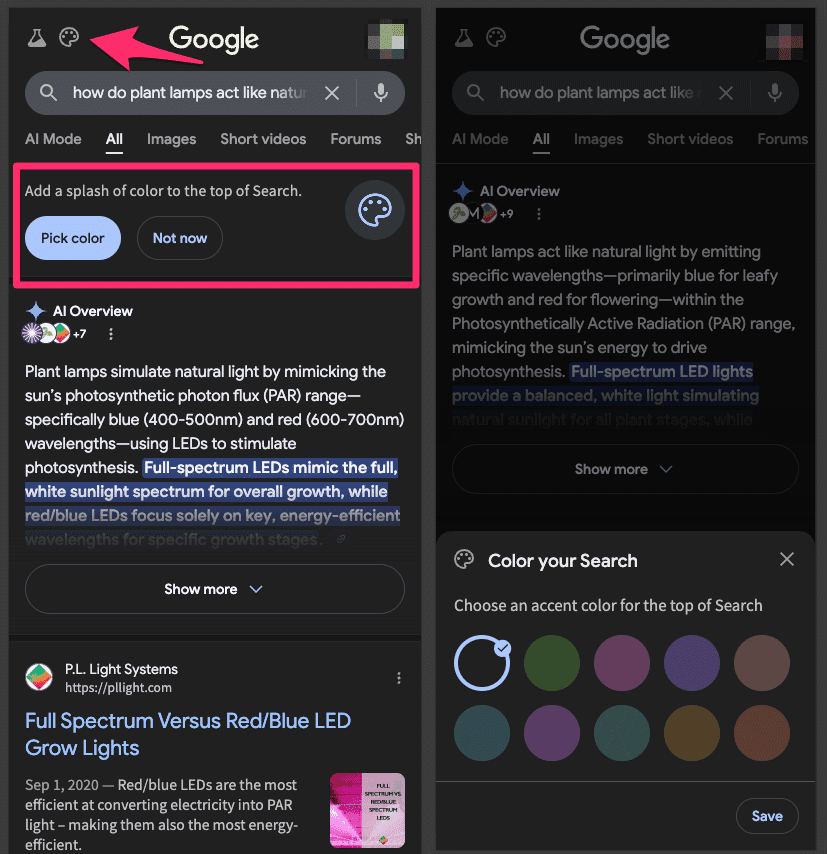

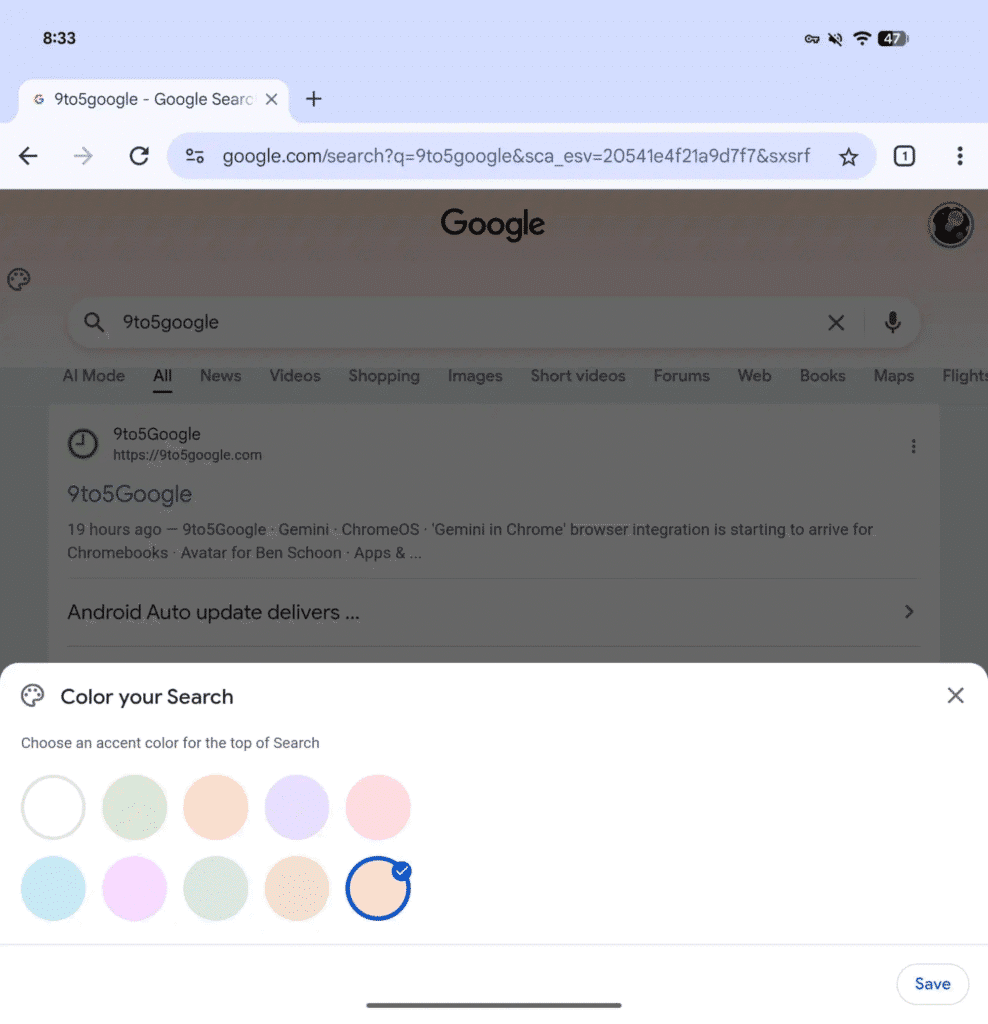

Oubliez le Dark Mode : Google propose 9 couleurs pastels pour votre affichage

Google teste une option très simple de personnalisation des résultats de recherche, appelée “Color your Search”. Un bouton en forme de palette apparaît en haut à gauche et propose le mode clair, le mode sombre et neuf couleurs pastel. Le changement concerne surtout le haut de la page, pas la liste des résultats.

Pourquoi c’est important ?

Même si cela paraît “cosmétique”, cela montre que Google veut rendre l’expérience Search plus personnalisable, surtout sur certains appareils. Pour une PME, c’est un rappel utile : l’interface peut évoluer vite. Il faut surveiller comment la marque apparaît dans Google, notamment en haut de page, où l’attention est la plus forte.

Conséquences sur le SEO et la stratégie de contenu

Il n’y a aucun impact SEO direct, car les résultats web ne changent pas. En revanche, si Google modifie davantage la zone supérieure (logo, éléments visuels, modules), la concurrence pour la visibilité “au-dessus de la ligne de flottaison” pourra se renforcer. Il devient important d’optimiser les titres, les méta-descriptions et les contenus qui déclenchent des blocs visibles.

Ici, Google modifie seulement la couleur d’accent et certains éléments visuels en haut de la page, comme le logo, pour adapter l’ambiance.

- Google Search tests basic ‘Color your Search’ theming Source : 9to5Google

- Google Search – Add Splash Of Color With Color Picker Source : Search Engine Roundtable

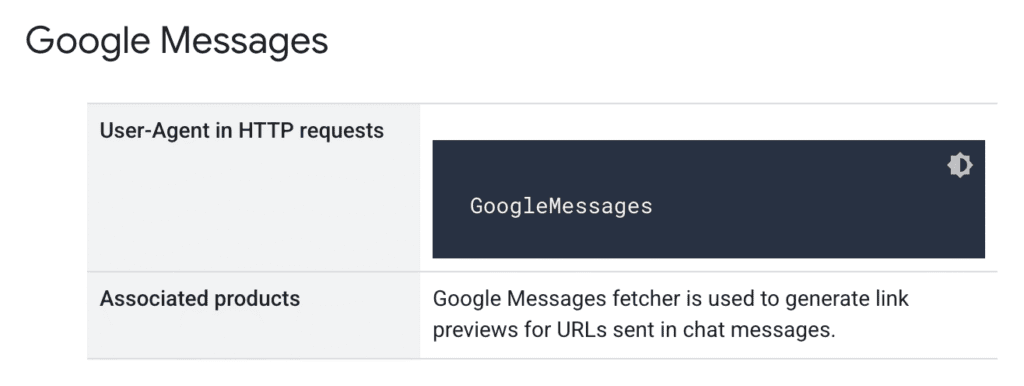

Google ajoute (encore) un nouveau crawler : Google Messages

Google a ajouté un nouveau robot nommé GoogleMessages dans sa documentation officielle. Ce robot sert uniquement à récupérer des pages afin de créer des aperçus de liens lorsque des URL sont partagées dans Google Messages. Cela aide les propriétaires de sites à identifier ce trafic spécifique dans leurs logs serveur.

- New GoogleBot: Google Messages Source : Search Engine Roundtable

3 nouveaux plugins vulnérables à surveiller sur WordPress en 2026

Cette semaine, Search Engine Journal a repéré 3 autres plugins WordPress présentant une vulnérabilité à corriger :

- 10Web Photo Gallery (≤ 1.8.36) : une vérification de permissions manquante permet à des attaquants non authentifiés de supprimer des commentaires d’images via la fonction delete_comment(). La faille touche uniquement la version Pro avec commentaires activés. Elle n’entraîne pas une prise de contrôle du site, mais peut provoquer des pertes de données et perturber l’engagement des utilisateurs.

- BuddyPress (≤ 14.3.3) : une validation insuffisante des entrées permet à des attaquants non authentifiés d’exécuter arbitrairement des shortcodes WordPress. Selon les shortcodes disponibles, cela peut exposer des fonctionnalités internes, afficher des données sensibles ou interagir avec d’autres plugins. La vulnérabilité est jugée élevée (7.3) et affecte tout site utilisant une version non corrigée.

- WP Go Maps (≤ 10.0.04) : une absence de contrôle de capacités autorise des utilisateurs authentifiés au niveau “Subscriber” à modifier les réglages globaux du moteur de cartes. Cette faille permet à des comptes peu privilégiés d’altérer le fonctionnement du plugin sur l’ensemble du site, ce qui peut impacter l’affichage des cartes et la fiabilité des informations locales.

- WP Go Maps Plugin Vulnerability Affects Up To 300K WordPress Sites Source : Search Engine Journal

- BuddyPress WordPress Vulnerability May Impact Up To 100,000 Sites Source : Search Engine Journal

- 10Web WordPress Photo Gallery Plugin Vulnerability Source : Search Engine Journal

Pour Sam Altman, OpenAI a “ruiné” la qualité de rédaction de ChatGPT-5.2

Sam Altman reconnaît qu’OpenAI a perdu en qualité d’écriture de GPT-5.2, jugée moins lisible que GPT-4.5. Il explique que l’équipe a priorisé le raisonnement, le code et l’ingénierie, faute de temps. Il promet que de futures versions GPT-5.x amélioreront l’écriture, sans calendrier précis.

Pourquoi c’est important ?

Si votre équipe utilise ChatGPT pour des emails, des propositions commerciales ou des contenus clients, une baisse de la qualité de rédaction peut ralentir la production et augmenter le risque d’erreurs de tone of voice. Ce type de régression rappelle qu’un modèle IA peut progresser sur certains usages et reculer sur d’autres. En déinitive, ce sera toujours à l’humain de bien vérifier les résultats donnés par l’IA.

Conséquences sur le SEO et la stratégie de contenu

Si vous produisez des pages, des articles ou des scripts avec l’IA, la qualité perçue peut varier après une mise à jour. Mettez en place une relecture systématique, des gabarits éditoriaux, et des tests A/B sur un échantillon. Mesurez l’impact via le taux de clic, le temps passé et les conversions, pas seulement le volume publié.

Comment limiter le risque de non-qualité des outputs quand un modèle d’IA change ?

Traitez l’IA comme un outil logiciel : à chaque changement, re-testez vos prompts sur 10 à 20 cas réels (emails, pages, posts). Conservez une “version de référence” de vos meilleurs prompts et exemples. Gardez aussi une solution de secours (autre modèle ou rédaction humaine) pour les textes critiques.

Pourquoi la capacié à mieux raisonner de ChatGPT a pu dégrader sa capacité d’écriture ?

OpenAI explique avoir concentré ses efforts sur le code et le raisonnement. Quand un modèle est optimisé pour des tâches techniques, il peut produire des textes plus longs, plus denses, et moins fluides. Une “point release” est une petite mise à jour progressive du modèle : elle peut changer le style sans prévenir.

- Sam Altman Says OpenAI “Screwed Up” GPT-5.2 Writing Quality Source : Search Engine Journal

- Sam Altman admet une baisse de qualité d’écriture sur GPT-5.2 Source : Position Zéro

12 mois après l’adoption de l’IA, 56% des entreprises n’ont toujours reçu aucun bénéfice

PwC a interrogé 4 454 dirigeants dans 95 pays. Résultat : 56% disent n’avoir constaté ni hausse de revenus ni baisse de coûts grâce à l’IA sur les 12 derniers mois. Environ 30% déclarent une hausse de revenus, 26% une baisse de coûts, et seulement 12% obtiennent les deux à la fois.

Pourquoi c’est important ?

Investir dans l’IA ne garantit pas un ROI rapide. Les entreprises doivent prioriser les cas d’usage utiles et mesurables, plutôt que de multiplier des tests dispersés. L’IA doit soutenir une stratégie business claire (vente, service, production), sinon le budget alloué risque de s’envoler sans résultat tangible.

Conséquences sur le SEO et la stratégie de contenu

Côté contenu, l’IA peut accélérer la production de l’entreprise, mais ce n’est pas forcément un gain en termes de chiffre d’affaires. Il devient essentiel de définir des objectifs précis (génération de leads, augmentation des demandes de démo, inscriptions à un évènement, etc.), de suivre les conversions, et d’éviter les contenus créés “en masse” sans intention de recherche ou objectif business clair.

Pourquoi si peu d’entreprises voient un ROI sur l’IA ?

PwC indique que des projets isolés, utilisés “au coup par coup”, donnent rarement une valeur mesurable. Les entreprises qui réussissent le mieux ont des bases stratégiques solides : une feuille de route, un environnement technique prêt à intégrer l’IA, et des règles d’utilisation responsable de l’IA, c’est à dire utiliser l’IA avec des règles de sécurité, de qualité et d’éthique.

Qu’est-ce que cela change pour le marketing B2B ?

Selon l’enquête, seuls 22% des dirigeants disent utiliser l’IA fortement pour la génération de demande (attirer et convertir des prospects). Cela suggère une adoption encore tôt dans les processus de l’entreprise. A vous de structurer dès maintenant les bons usages pour votre entreprise que tout vos concurrents ne le fassent.

- 56% Of CEOs Report No Revenue Gains From AI: PwC Survey Source : Siècle Digital

ChatGPT cite Grokipedia dans ses résultats : attention à la crédibilité de vos sources

Une enquête du Guardian indique que GPT-5.2 cite parfois Grokipedia, une encyclopédie générée par l’IA d’Elon Musk. Les journalistes auraient trouvé 9 citations sur une quinzaine de requêtes, surtout sur des sujets techniques ou peu médiatisés. Problème : Grokipedia n’a pas d’édition humaine ni de correction communautaire.

Pourquoi c’est important ?

Beaucoup de professionnels utilisent l’IA pour comprendre un marché, un secteur ou un sujet sensible rapidement. Si les sources citées sont contestables, une décision peut se baser sur une information biaisée, sans le savoir. Le risque augmente quand les sujets sont complexes et difficiles à vérifier, là où l’IA semble justement la plus “pratique”.

Conséquences sur le SEO et la stratégie de contenu

La crédibilité d’un contenu passe par des sources claires et vérifiables. En rédaction web sur des sujets B2B, privilégiez des pages qui citent des références solides, expliquent les limites, et distinguent faits et interprétations. Mettez à jour les contenus sensibles, ajoutez une section “Sources”, et mesurez l’impact via la confiance (leads qualifiés, demandes de contact).

Pourquoi une IA qui cite une IA est risqué ?

Une citation IA donne une impression de validation à l’utilisateur, qui pense que la source a été vérifiée et recoupée. Or, Nina Jankowicz, spécialiste de la désinformation, souligne que cela peut “légitimer” artificiellement une source fragile. Une information douteuse peut donc paraître crédible, simplement parce qu’elle est citée.

Qu’est-ce que le LLM grooming ?

Le LLM grooming est un phénomène où des modèles de langage utilisent des contenus produits par d’autres IA. Le risque est une boucle d’auto-validation : une information biaisée circule, est reformulée, puis revient sous une forme plus neutre, tout en restant difficilement fiable. Cette pratique rend les erreurs plus difficiles à repérer.

- ChatGPT cite Grokipedia : la fiabilité des IA déjà fragilisée ? Source : Siècle Digital

- Latest ChatGPT model uses Elon Musk’s Grokipedia as source, tests reveal Source : The Guardian

ChatGPT adapte ses réponses selon l’âge estimé de l’utilisateur

OpenAI annonce que ChatGPT va estimer l’âge des utilisateurs à partir de leurs usages, sans demander systématiquement une pièce d’identité. L’objectif est d’adapter les contenus proposés, notamment pour les mineurs, tout en maintenant l’accès aux fonctions éducatives et informatives. Cette approche repose sur des signaux comportementaux observés dans le temps.

Conséquences sur le SEO et la stratégie de contenu

Cette segmentation par âge renforce l’importance d’un contenu clair, responsable et contextualisé. Les marques devront produire des contenus adaptés à différents niveaux de maturité, éviter les sujets sensibles mal encadrés et renforcer la pédagogie. Cela peut impliquer des pages explicatives, des avertissements clairs et une mesure qualitative de l’engagement.

Comment ChatGPT estime-t-il l’âge de ses utilisateurs ?

OpenAI n’utilise pas un contrôle d’identité à l’inscription. ChatGPT analyse plutôt des signaux comme l’ancienneté du compte, les horaires de connexion et les habitudes d’usage. L’âge déclaré reste pris en compte, mais il est croisé avec ces données pour détecter un profil potentiellement mineur.

Quelles restrictions s’appliquent aux comptes mineurs ?

Lorsque ChatGPT identifie un utilisateur comme mineur, certains contenus sont limités. Cela concerne notamment la violence graphique, l’automutilation, les jeux de rôle romantiques ou sexuels, ainsi que des défis dangereux. OpenAI souhaite aussi réduire la visibilité de contenus liés à des standards de beauté extrêmes ou à des pratiques alimentaires à risque.

Que se passe-t-il en cas d’erreur d’estimation ?

OpenAI prévoit un mécanisme de correction. Si un adulte est identifié à tort comme mineur, il pourra rétablir l’accès complet via une vérification d’identité, par selfie ou document officiel. En Europe, le déploiement sera progressif pour respecter le RGPD, et un futur « mode adulte » est également envisagé.

- Notre approche en matière de prédiction de l’âge Source : OpenAI

- ChatGPT va estimer votre âge pour adapter ses contenus sans bloquer l’accès Source : Siècle Digital

Le point sur le Google AI Mode

Voici les dernières informations que j’ai trouvées sur le Google AI Mode.

- Google AI Overviews follow up questions jump you directly to AI Mode Source : Search Engine Land

- Google brings Personal Intelligence to AI Mode in Google Search Source : Search Engine Land

- Google AI Mode Tests Product Images With Price Labels Source : Search Engine Roundtable

Le point sur les Google AI Overview

Je ne le présente plus, comme chaque semaine, voici les dernières informations que j’ai trouvées sur les AI Overviews.

- Gemini 3 Powering Google AI Overviews Globally Source : Search Engine Roundtable

- Google Falls Back To Featured Snippets When AI Overviews Don’t Generate Source : Search Engine Roundtable

- How to Track AI Overviews: Mentions, Citations, Click Loss, and the Traffic Google Won’t Show You Source : Ahrefs

Retrouvez aussi mes dernières publications sur le LinkedIn de @Plume Numérique et de @Sandrine Lasserre

Les articles publiés cette semaine sur le blog de Plume Numérique

Voir tous les articles du blog

0 commentaires