TL;DR : IA, ads et SEO : Claude reste sans pub, Google est sous pression, et la visibilité se joue désormais sur citations, marque et multi-plateformes.

Le SEO et la visibilité digitale entrent dans une phase de rupture. Entre l’arrivée de la publicité dans certains assistants IA, la baisse des clics Google, les limites de mesure des outils et les nouvelles régulations, les repères classiques ne suffisent plus pour piloter une stratégie d’acquisition.

Une marque peut aujourd’hui perdre du trafic sans perdre d’impact business, disparaître des réponses IA sans chute de positions, ou être citée sans générer de clic. Les comparatifs auto-promotionnels chutent, les données de la Search Console sont incomplètes, et les IA redistribuent l’attention sans transparence claire. Résultat : décisions biaisées, budgets mal arbitrés et sentiment de perte de contrôle.

Cette revue du digital aide à comprendre ce qui change réellement : comment les IA influencent la découverte, pourquoi le SEO devient aussi un canal de marque, quels contenus résistent, et comment adapter la mesure de performance en 2026.

Voici les sujets à retenir cette semaine, et ce qu’ils changent concrètement pour votre SEO et votre stratégie de contenu.

- Publicité & IA : 2 visions qui s’opposent dans les LLM : Tout comme Gémini, Claude reste sans ads (confiance/neutralité), et ChatGPT bascule vers la monétisation (logique d’influence, pas de clic).

- Le SEO est un levier de marque autant que de trafic : avec l’IA et le zero-click, moins de sessions ne veut pas dire moins de pipeline → il faut mesurer votre ROI autrement.

- Visibilité IA multi-plateformes : ne pas miser sur un seul assistant IA → ChatGPT domine au global, mais Copilot/Claude/Perplexity sont fortement représentés sur certains secteurs d’activités et usages de l’IA.

- Les signaux de crédibilité deviennent déterminants sur les contenus d’aide à la décision : recul des listicles auto-promo “meilleur X” → les comparatifs doivent être plus transparents, et l’affichage d’une méthodologie et de preuves sociales devient indispensable.

- Les biais de la Google Search Console : les données fournies sont potentiellement très filtrées et il n’y a pas (encore) de reporting IA fiable : évitez les décisions mono-source.

- Les nouvelles limites de crawl : Googlebot lit désormais une partie limitée des fichiers sur votre site web : l’essentiel doit être placé vers le début des pages HTML mais aussi des ressources téléchargeables.

- Régulation & gouvernance de l’IA : une avancée dans le procès antitrust US + une pression UE sur la rémunération des auteurs de contenus → risque de redistribution du trafic, des coûts et des règles du jeu.

Bonne lecture !

Table des matières

Claude AI non plus n’aura pas d’ads ! (du moins pour l’instant)

Anthropic annonce que son assistant IA Claude restera sans publicité, contrairement à ChatGPT. ’entreprise estime que la publicité dans des conversations IA nuirait à la confiance, introduirait des biais invisibles et entrerait en conflit avec les usages réels des assistants IA, souvent liés au travail ou à des sujets sensibles.

Pourquoi c’est important ? Pour les dirigeants, l’affichage (ou non) de publicité directement dans les réponses des IA génératives impacte le choix des outils internes et partenaires technologiques. Un assistant IA sans publicité semblera plus neutre dans l’aide à la prise de décision, là où un modèle financé par la publicité peut introduire des logiques commerciales indirectes.

- Anthropic says Claude will remain ad-free as ChatGPT tests ads Source : Search Engine Land

ChatGPT ne sera pas un canal publicitaire classique

L’arrivée de la publicité dans ChatGPT marque une rupture avec les logiques classiques du search et des réseaux sociaux. Le LLM offre un environnement orienté vers l’action, où l’utilisateur cherche à résoudre un problème précis. La réussite des annonceurs dépendra de la compréhension fine des comportements humains par l’algorithme.

Comment mesurera-t-on l’efficacité des publicités dans ChatGPT ?

Les clics ne suffiront pas, car une publicité peut influencer un internaute sans déclencher d’action immédiate. Les KPI pertinents deviennent la mémorisation de marque, l’entrée dans une shortlist de quelques marques, et l’augmentation du nombre de recherches de marque ou du trafic direct. Cela impose une mesure plus globale et un alignement entre SEO, contenu et paid media.

- OpenAI quietly lays groundwork for ads in ChatGPT Source : Search Engine Land

- Ads in ChatGPT: Why behavior matters more than targeting Source : Search Engine Land

Procès contre Google : les US font appel et relancent la bataille du search

Les États-Unis et une majorité d’États américains font appel des décisions prise par le juge dans l’affaire antitrust contre Google. Le juge Amit Mehta a confirmé en 2024 un monopole illégal dans la recherche, mais a refusé les mesures les plus dures comme la vente de Chrome par sa maison-mère Alphabet. Les débats portent surtout sur Chrome, les accords de recherche par défaut et le partage de données.

Pourquoi c’est important ? Cette affaire peut modifier les règles du jeu de l’acquisition. Si les accords “par défaut” sont davantage limités, de nouveaux acteurs pourraient gagner en visibilité. Cela peut changer les coûts publicitaires, la répartition du trafic et la dépendance à Google. Pour une PME, cela touche directement la stratégie de croissance, le budget marketing et le risque de concentration.

Conséquences sur le SEO et la stratégie de contenu Les solutions retenues évoquent la fin du monopole de Google, une renégociation annuelle des contrats de recherche et d’apps IA, et un partage de certaines données de recherche avec des concurrents. Concrètement, il faut prévoir plus de diversité de sources de trafic, suivre les changements par appareil, et renforcer des contenus qui répondent clairement aux besoins business.

- DOJ and states appeal Google search antitrust remedies ruling Source : Search Engine Land

- Google can keep Chrome, but exclusive search deals must end Source : Search Engine Land

- Google Search Ruling to be Appealed by DOJ, States Source : Bloomberg (Accès payant)

- US files appeal in Google search antitrust case Source : Reuters

Réglementation UE : faudrait-il indiquer quelles sections de votre page ont été générées par IA ?

Une proposition technique suggère d’utiliser des balises HTML pour indiquer quelles parties d’une page web sont générées par intelligence artificielle. L’objectif est de répondre aux obligations du futur AI Act européen. Mais cette solution divise, car elle détourne des balises prévues pour la structure du contenu, avec des risques pour l’accessibilité et la clarté du web.

Pourquoi c’est important ? Les nouvelles règles européennes imposeront de signaler le contenu généré par IA. Cette proposition pourrait créer des obligations techniques supplémentaires pour les sites web. Pour un dirigeant, cela signifie anticiper des coûts de mise en conformité, des choix techniques à trancher, et un risque juridique si les obligations sont mal interprétées ou mal implémentées.

Conséquences sur le SEO et la stratégie de contenu.Baliser des sections comme “généré par IA” ou “100% humain” pourrait influencer la façon dont les moteurs et les assistants IA lisent une page web. Une mauvaise utilisation de balises sémantiques peut nuire à l’accessibilité et à la compréhension du contenu. La priorité reste donc une structure claire, lisible, et centrée sur l’utilisateur, avant toute logique de conformité.

Qu’e propose’implique exactement ce système d'”AI disclosure” ?

La proposition prévoit deux niveaux de signalement. Un méta-tag indique la part globale de contenu généré par IA sur une page. Des attributs HTML peuvent aussi marquer des sections précises comme “IA”,”assisté par IA” ou “sans IA”. L’idée est de fournir une information lisible par les machines, exigée par la loi européenne.

Problème : les balises HTML ont un rôle précis → structurer le sens du contenu pour les navigateurs et les lecteurs d’écran. Les utiliser pour indiquer l’origine du texte détourne leur fonction. Une synthèse, même générée par IA, reste liée au contenu principal et n’est pas toujours un simple élément “annexe”.

Le débat est encore en cours au Parlement Européen

Le débat n’est pas tranché. Certains estiment que cette proposition répond surtout à une obligation réglementaire, sans bénéfice clair pour les utilisateurs. D’autres craignent une inflation de balisage technique qui complique le web et l’accessibilité. Le risque est d’ajouter une couche de conformité sans améliorer réellement la qualité de l’information en ligne.

- Why Proposal To Label Sections Of AI Generated Content Is Controvesial Source : Search Engine Journal

Faudra-il payer les créateurs de contenu dont le contenu est utilisé par les IA ?

Un rapport adopté en commission demande que l’usage de contenus protégés pour entraîner ou faire fonctionner une IA soit soumis à une autorisation préalable, avec une rémunération « équitable » et plus de transparence. Un vote est prévu en mars.

Pourquoi c’est important ? Ces règles peuvent changer vos coûts et vos risques juridiques si votre entreprise utilise des outils d’IA avec des contenus protégés. Elles peuvent aussi affecter votre visibilité. Il faudra clarifier les droits, sécuriser les fournisseurs de contenu, et anticiper d’éventuelles sanctions.

Conséquences sur le SEO et la stratégie de contenu. Si les IA réutilisent l’information en la redistribuant, certains contenus peuvent perdre du trafic et des revenus. La stratégie de contenu doit donc renforcer la valeur “sur site” : pages utiles, sources claires, contenus différenciants. Côté SEO, surveillez les variations de trafic et la part d’audience venant de plateformes d’IA.

Les conséquences d’une rémunération plus juste des auteurs

Le Parlement souhaite que le droit d’auteur européen s’applique à toute IA générative accessible dans l’Union européenne, même si elle a été conçue ou entraînée ailleurs. L’objectif est d’éviter un contournement simple : proposer en Europe une IA “venue d’ailleurs” sans respecter les mêmes obligations.

Cependant les parlementaires craignent que certaines IA agrègent et redistribuent l’information de façon sélective (pour plus de facilités de gestion). Cela pourrait détourner une partie du trafic et des revenus des éditeurs qui travaillent ave l’Europe mais aussi d’autres pays, tout en poussant quelques sources au détriment d’autres slon votre provenance géographique.

- L’Europe veut forcer les géants de l’IA à passer à la caisse pour rémunérer les créateurs et les médias Source : Siècle Digital

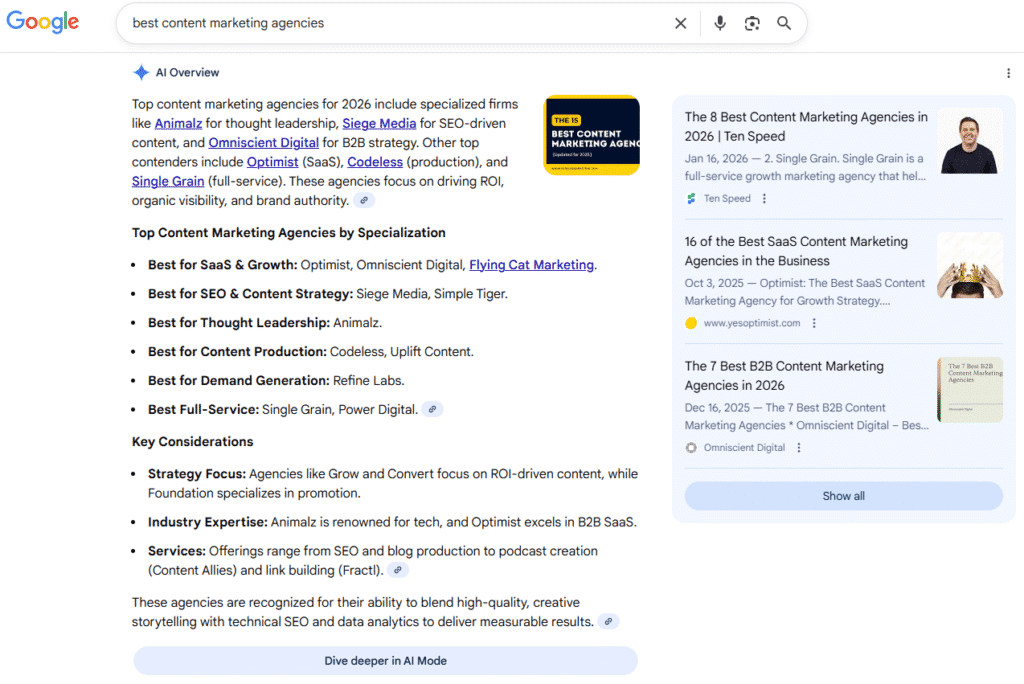

Les listicles auto-promotionnels c’est fini sur Google !

Des recherches suggèrent que Google pénalise davantage les articles de ‘meilleur X’ ou ‘Top Y’ où une entreprise se classe elle-même n°1 (sans véritable justificatif). Après la core update de décembre 2025, plusieurs marques SaaS ont perdu 30 à 50% de visibilité, surtout dans les dossiers blog, guides et tutoriels, souvent remplis de ces listes.

Source : Lily Ray NYC

Pourquoi c’est important ? Si votre acquisition dépend de comparatifs produit orientés vente, le risque de perdre des positions sur Google augmente. Une baisse de visibilité peut réduire les leads, augmenter la pression sur le paid, et fragiliser la confiance dans votre marque. Ces pages étaient aussi utilisées pour influencer les réponses des IA. Si elles chutent, votre présence “dans l’IA” peut chuter aussi.

Conséquences sur le SEO et la stratégie de contenu Auditez vos comparatifs et repérez ceux qui se contentent d’ajouter “2026” sans vraies mises à jour. Priorité aux contenus d’évaluation crédibles : méthodologie claire, preuves, limites, et transparence sur les biais. Surveillez les baisses par sous-dossiers, pas seulement au niveau du domaine, et mesurez aussi la visibilité dans les IA.

Pourquoi les listicles deviennent un problème de contenu SEO ?

Un “listicle” est un article en liste (“les 10 meilleurs…”). Choisir comme titre “le meilleur X” suggère une comparaison honnête. Or, beaucoup de pages se classent elles-mêmes en n°1 sans test indépendant, sans méthode, et sans preuve. Google recommande des avis basés sur une expérience réelle et des éléments vérifiables.

Les pertes de visibilité touchent surtout les blogs, guides et tutoriels. Les baisses sont concentrées dans des répertoires de contenu, parfois avec des centaines d’articles très similaires. Plusieurs signaux de risque reviennent : production rapide à grande échelle, automatisation, rafraîchissements artificiels des dates, et usage massif du millésime dans les titres. Le reste du site peut moins bouger.

Quel lien entre listicle et visibilité dans les IA (ChatGPT, AI Overviews) ? Ces pages influencent aussi les réponses d’IA, car certaines IA reprennent des informations déjà visibles dans Google. Un système “RAG” (réponse construite à partir de sources récupérées) peut citer ce qui ressort dans les résultats. Si Google réduit la visibilité de ces pages, les citations IA peuvent baisser aussi.

- Google may be cracking down on self-promotional ‘best of’ listicles Source : Search Engine Land

- Is Google Finally Cracking Down on Self-Promotional Listicles? Source : Lily Ray NYC

Ce qui fonctionne pour créer de la visibilité à l’ère de la recherche IA

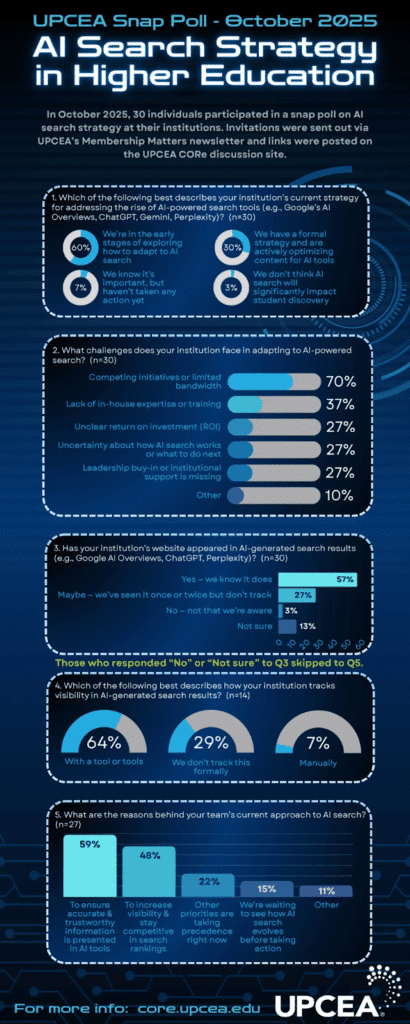

Une étude sur l’enseignement supérieur montre que le SEO ne disparaît pas avec l’AI search. Il faut à la fois bien se classer sur Google et être cité dans les réponses IA. Les AI Overviews de Google apparaissent sur ~21% des mots-clés (Ahrefs) et sont presque toujours déclenchés par des recherches informationnelles.

Pourquoi c’est important ? L’IA influence la confiance des internautes envers votre marque plus tôt dans le parcours. Dans l’étude, 56% font davantage confiance à une marque citée par l’IA, et 79% lisent les AI Overviews quand ils les voient. Si votre marque n’est pas citée, elle peut sortir du “premier choix” avant même la comparaison des offres.

Conséquences sur le SEO et la stratégie de contenu. La visibilité devient “cumulative” : l’IA assemble des réponses à partir du site, de YouTube, de LinkedIn et de sources tierces. Les contenus qui gagnent sont structurés pour être repris facilement : réponses directes, titres alignés sur les questions, sections autonomes, pages de comparaison et d’aide à la décision. Mesurez les citations, pas seulement les positions.

Pourquoi l’autorité ne suffit plus pour être cité ?

L’étude montre que même des universités, pourtant très reconnues et riches en contenus, peuvent être écartées si leurs pages ne correspondent pas à la façon dont les gens posent leurs questions. L’IA ne cherche pas “la meilleure marque”. Elle cherche “la meilleure réponse”, souvent dans des formats comme les comparatifs et les listes.

Pourquoi les organisations avancent lentement malgré l’enjeu ? Le sondage UPCEA montre un décalage : 60% explorent seulement le sujet, 30% ont une stratégie formelle, 10% n’ont pas commencé ou pensent l’impact limité. Les freins cités sont très concrets : 70% manquent de temps, 37% manquent de compétences, 27% évoquent un ROI flou ou un manque d’adhésion.

- What higher ed data shows about SEO visibility and AI search Source : Search Engine Land

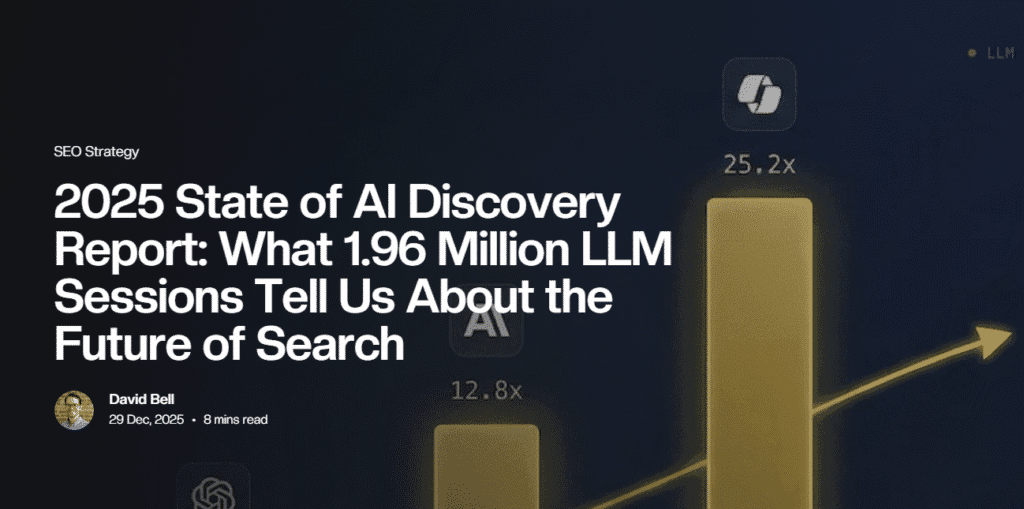

AI discovery : Pourquoi vous ne devez pas vous concentrer sur une seule plateforme ?

Une analyse de près de deux millions de sessions LLM en 2025 montre que ChatGPT capte 84,1% du trafic d’”AI discovery”, mais que les usages diffèrent selon les secteurs. Copilot et Claude grandissent plus vite. Perplexity tient surtout en finance. Gemini pose un problème de mesure car il garde l’utilisateur dans l’interface.

Pourquoi c’est important ? Une stratégie « tout sur ChatGPT » devient risquée. Vos prospects ne découvrent pas tous l’information au même endroit, ni au même moment du cycle d’achat. Copilot progresse là où le travail se fait déjà (Microsoft). Claude influence des profils experts. Votre priorité devient d’être visible au bon endroit, pas seulement partout.

Conséquences sur le SEO et la stratégie de contenu. Il faut penser à la fois au classement et la citation IA. Diversifiez les formats et les canaux de diffusion : site, YouTube, LinkedIn, médias tiers. Produisez des contenus comparatifs et décisionnels, pas seulement narratifs. Côté mesure, surveillez le branded search et les conversions décalées : l’attribution (relier une vente à une source) devient moins fiable.

Les IA à privilégier selon votre secteur d’activité

Pourquoi Microsoft Copilot devient-il central en marketing digital B2B ? Parce que Copilot se situe là où le travail se fait : Excel, Outlook, Teams, etc. Les utilisateurs n’ouvrent pas un moteur de recherche séparé, ils demandent directement à l’IA d’interpréter des données et d’avancer une tâche. La visibilité se joue donc pendant l’exécution, quand l’intention est élevée.

Pourquoi Perplexity est fortement utilisé en finance ? La finance exige de pouvoir vérifier rapidement des informations nouvelles. Perplexity garde une part importante en finance (24%) car il fournit des sources visibles et traçables, et s’appuie sur des partenariats (données, transcriptions, dépôts). Dans ces décisions à risque, la rapidité ne suffit pas : la preuve et la citation comptent plus que la synthèse.

- 2025 State of AI Discovery Report: What 1.96 Million LLM Sessions Tell Us About the Future of Search Source : Prévisible.io

- What 2 million LLM sessions reveal about AI discovery Source : Search Engine Land

AI discovery : comment LinkedIn booste votre visibilité en 2026

LinkedIn a testé ce qui améliore la visibilité des contenus dans les résultats générés par l’IA. Les résultats montrent que la structure du contenu, l’usage de balises HTML claires, l’expertise des auteurs identifiés et la présence de dates jouent un rôle clé. La visibilité ne dépend plus uniquement des clics.

Pourquoi c’est important ? Les décideurs B2B sont de plus en plus exposés aux marques via des réponses générées par l’IA, souvent sans visiter de site. Pour une PME, cela signifie que la notoriété et la crédibilité peuvent se construire avant tout contact commercial. Être cité ou mentionné devient un levier d’influence stratégique.

Conséquences sur le SEO et la stratégie de contenu. Le SEO ne se limite plus au trafic web. Les contenus doivent être structurés pour être compris par l’IA : titres hiérarchisés, sections claires et HTML sémantique. Il faut aussi renforcer les signaux de confiance : auteurs identifiés, expertise visible et contenus à jour. De nouveaux indicateurs complètent désormais les visites.

Pourquoi la structure du contenu est-elle devenue si importante ?

Les outils d’IA analysent les contenus par fragments, et non comme une page entière. Une structure claire aide l’IA à mieux comprendre chaque partie, et comment s’agence le tout. Des titres logiques et une hiérarchie simple permettent aux modèles de repérer rapidement les réponses utiles et de les citer plus facilement.

Le rôle de l’auteur et la date de publication : Les contenus signés par des experts identifiés et datés inspirent davantage confiance aux systèmes d’IA. Une date visible montre que l’information est récente. Un auteur nommé, avec une expertise claire, renforce la crédibilité. À l’inverse, les contenus anonymes ou non datés sont moins souvent mis en avant.

- LinkedIn Shares What Works For AI Search Visibility Source : Search Engine Journal

- How LinkedIn Marketing Is Adapting to AI-Led Discovery Source : LinkedIn

Budget crawl : combien d’URL Googlebot peut-il crawler au maximum ?

Google a mis à jour deux documents d’aide pour clarifier les limites de lecture de Googlebot lors du crawl. Par défaut, ses robots ne lisent plus que le début des fichiers : 15 MB pour une page web, 2 MB pour certains fichiers “supportés”, et jusqu’à 64 MB pour un PDF.

Pourquoi c’est important ? Si vos pages clés, vos fiches techniques ou vos PDF sont très lourds, une partie du contenu peut être ignorée par Google. Cela peut réduire la visibilité sur des requêtes importantes, sans que le problème soit évident. Connaître ces limites aide à prioriser la clarté et l’accessibilité des contenus business.

Conséquences sur le SEO et la stratégie de contenu. Assurez-vous que l’information essentielle (bénéfices, preuves, spécifications, FAQ, CTA) se trouve tôt dans la page ou le PDF. Évitez les pages qui “cachent” le contenu après de longues sections. Pensez aussi que chaque ressource (CSS, JavaScript) est récupérée séparément, avec les mêmes limites, ce qui peut influencer l’indexation.

Pour bien comprendre les nouvelles limites de crawl de Googlebot

Google part du principe que le contenu éditorial principal vit dans le HTML, et que les documents autres servent à consultation ponctuelle.

Les nouvelles limites à respecter seront donc :

- Page HTML : 15 Mo max

- Autres fichiers : 2 Mo

- PDF : 64 Mo

Tout est calculé après décompression et le contenu après la limite est ignoré par Google. La limite de 2 Mo concerne surtout les fichiers non-HTML que Google peut indexer comme du texte, par exemple :

- .rtf

- .txt (fichiers texte)

- .csv (données tabulaires simples)

- .xml (sitemaps, flux, documents structurés)

- .json (données structurées lisibles)

- .doc / .docx

- .ppt / .pptx

- .xls / .xlsx

- .odt / .ods / .odp

Petites précisions. La limite de crawl s’applique aux données une fois décompressées, c’est-à-dire à la taille réelle du fichier après ouverture. Un fichier qui semble léger au téléchargement peut être beaucoup plus gros une fois décompressé. Résultat : Googlebot peut s’arrêter avant la fin et n’indexer que la partie déjà téléchargée.

- Google lists Googlebot file limits for crawling Source : Search Engine Land

- Google Updates Googlebot File Size Limit Docs Source : Search Engine Journal

- Googlebot File Limit Is 15MB But 64MB For PDF & 2MB For Other File Types Source : Search Engine Roundtable

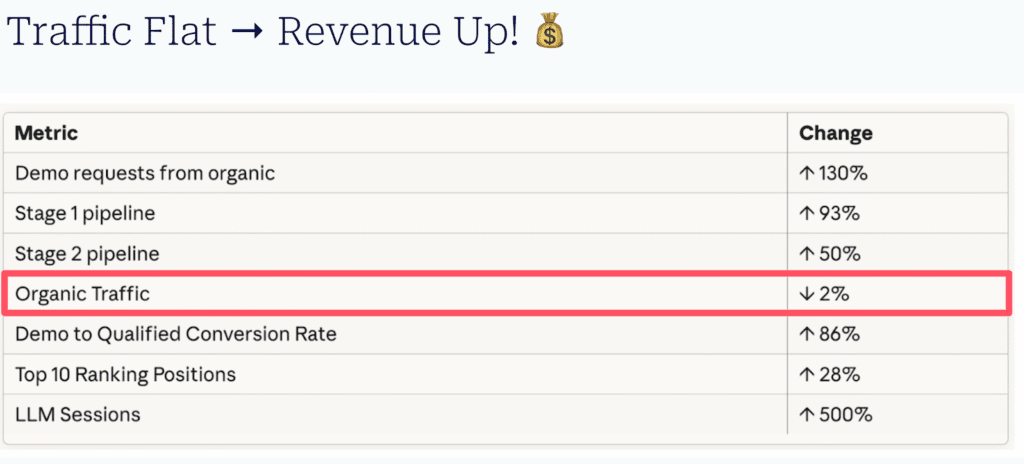

La fin du trafic SEO : votre ROI dépend de votre image de marque, pas de votre positionnement

Le modèle classique du SEO “+ de positions SEO = + de trafic = + de leads” est en train de disparaître. Avec les AI Overviews, le zero-click et les réponses des LLM, il y a moins de clics même en bonne position. Le SEO reste utile, mais il agit aussi comme un levier de marque et d’influence.

Pourquoi c’est important ? Si vous pilotez votre stratégie SEO uniquement au trafic, vous risquez de couper un levier qui apporte du chiffre d’affaires. Dans certains cas, Search Engine Land a constaté que le nombre de sessions baisse, mais où le pipeline commercial et les demandes de démo augmentent. La question devient : comment prouver le ROI sans se limiter aux clics, et où investir en priorité.

Conséquences sur le SEO et la stratégie de contenu. Ne cherchez pas à “regonfler” votre trafic avec du contenu trop général. Concentrez-vous sur les pages produit, solution et comparaison, et sur les mots-clés commerciaux/BOFU. Mesurez les données suivantes : trafic vers les money pages, visites de la home (signal de demande), valeur du trafic, leads/pipeline par visiteur, et arrivées depuis des LLM.

Pourquoi le trafic et le pipeline commercial sont décorrelés ?

Les parcours d’achat ressemblent à une bille de flipper : une réponse en AI Overview, une vérification sur Reddit, une comparaison sur G2, puis une conversion plus tard en direct. Cette complexité échappe aux outils d’attribution classiques. Une baisse de sessions peut surtout toucher des recherches informationnelles, alors que les visites restantes sont plus proches de l’achat.

Pourquoi l’IA rend-elle le SEO dépendant de l’image de marque ?

Les moteurs de recherche basés sur des LLM ne se contentent pas de faire correspondre des mots-clés. Ils cherchent une forme de “consensus” sur le web : avis clients, citations dans des contenus experts, présence à côté des leaders, clarté du positionnement. Une réputation faible limite la performance, même avec une optimisation technique propre.

Quelles preuves de branding montrer dans votre stratégie SEO (au lieu du trafic) ?

Voici les nouveaux KPI à suivre en 2026 : stabilité des top positions sur les mots-clés commerciaux, hausse de la valeur du trafic (même si les sessions baissent), trafic stable sur les pages produit/solution/comparaison, croissance de la home (proxy de demande de marque), émergence de referrals depuis ChatGPT/Gemini/Perplexity, et pipeline par visiteur en hausse.

- Is SEO a brand channel or a performance channel? Now it’s both Source : Search Engine Land

Sondage : ⅓ des éditeurs de site veut bloquer les AI Overviews

Google dit explorer un moyen pour que les sites refusent l’usage de leurs contenus dans ses fonctions de recherche IA, comme AI Overviews et AI Mode. Un sondage de plus de 350 réponses montre un débat partagé : 33,2% bloqueraient, 41,9% ne bloqueraient pas, et 24,9% ne savent pas encore.

Pourquoi c’est important ? Si Google réutilise votre contenu dans des réponses IA, cela peut changer votre visibilité et vos clics. Bloquer peut protéger votre trafic, mais peut aussi réduire votre présence dans ces nouveaux formats. Ne pas bloquer peut apporter de l’exposition. Vous devrez décider en fonction de vos objectifs business et de votre dépendance à Google.

Conséquences sur le SEO et la stratégie de contenu : pour l’instant, Google “explore” seulement une option. Dès qu’un mécanisme sera disponible, il faudra tester. Mesurez l’impact sur la visibilité, les clics et les conversions. Préparez un suivi séparé pour les pages souvent reprises en résumés et celles qui soutiennent vos pages business via le maillage interne.

Ce que le sondage révèle

La décision de bloquer ou non les crawlers ressemble à un pari, car on ne connaît pas encore le réglage exact ni sa facilité d’usage. Si c’est simple, plus de sites pourraient le faire. Si c’est compliqué, moins de sites tenteront. Et surtout, l’effet réel sur le trafic et la notoriété ne pourra être compris qu’avec des tests.

Le sondage montre trois groupes :

- une minorité significative prête à bloquer (environ un tiers),

- une majorité relative qui préfère laisser faire,

- et un quart qui attend de voir.

Cela indique une incertitude forte, pas une règle claire. Beaucoup d’acteurs veulent des preuves avant de prendre une décision qui peut coûter cher.

Selon le Press Gazette, une grande partie des sites d’actualité UK/US bloqueraient déjà au moins un robot utilisé pour l’entraînement d’IA (comme GPTBot, ClaudeBot, etc.). Même si ce n’est pas exactement la recherche IA de Google, cela montre une tendance : certains éditeurs protègent activement leurs contenus pour éviter d’être dépossédé de leur création.

- 1/3rd of publishers say they will block Google Search AI-generative features like AI Overviews Source : Search Engine Land

- Poll: 33% Will Block Google AI Search Experience: AI Mode & AI Overviews Source : Search Engine Roundtable

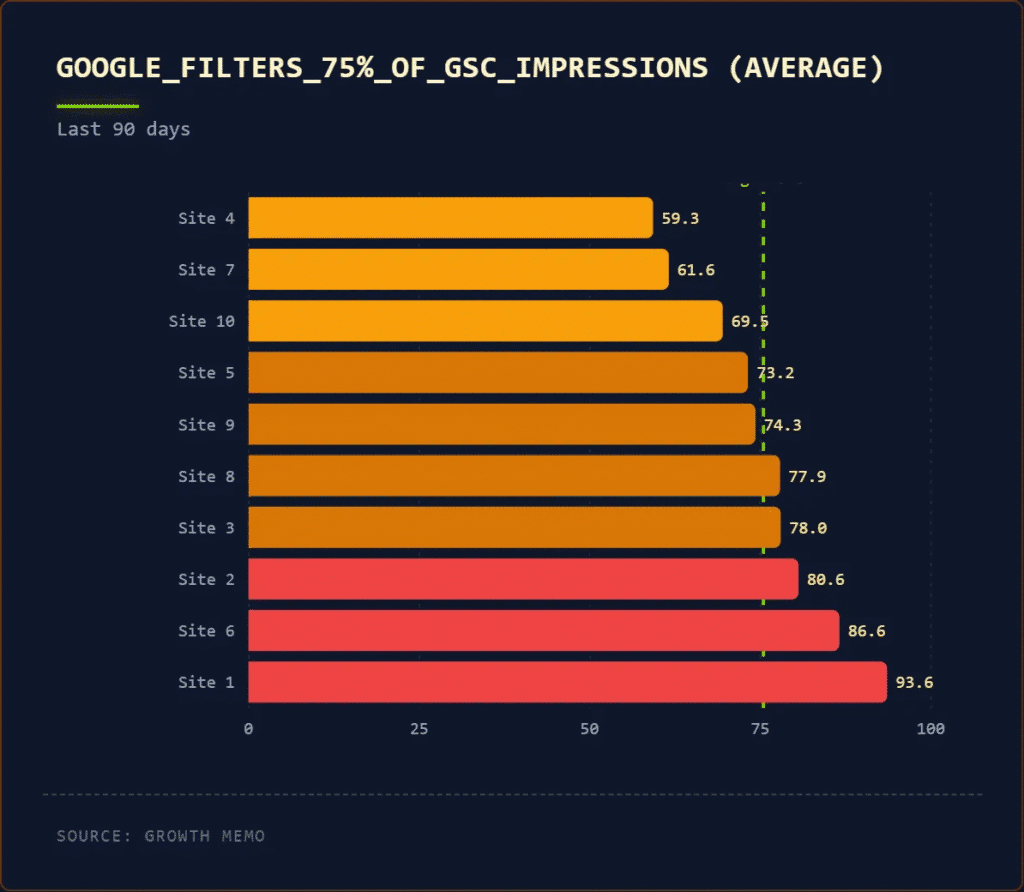

75% des données Google Search Console sont incomplètes

Une analyse de 10 sites B2B SaaS (environ 450 millions d’impressions et 4 millions de clics) mené par Growth Memo conclut que la Google Search Console (GSC) ne montre qu’une partie des données de votre site web. Selon l’auteur, environ 75% des impressions et 38% des clics seraient filtrés pour “privacy”. D’autres facteurs brouillent aussi la lecture.

Pourquoi c’est important ? Si vos décisions marketing reposent uniquement sur la GSC, votre pilotage se fait partiellement à l’aveugle. Cela crée des risques : investir sur de mauvais sujets, couper des budgets utiles, ou juger trop vite une stratégie SEO, un contenu, ou une refonte.

Conséquences sur le SEO et la stratégie de contenu : Évitez les décisions “mono-source” basées uniquement sur GSC. Croisez avec d’autres signaux : positions, conversions, demandes entrantes, et évolution des clics par type de requêtes. Surveillez les requêtes informationnelles, plus exposées aux AI Overviews. Dans vos analyses, distinguez baisse de clics liée au contenu (progressive) et baisse “brutale” (effet interface).

- GSC Data Is 75% Incomplete Source : Search Engine Journal

- GSC data is 75% incomplete Source : Growth Memo

La Google Search Console va-t-elle ajouter un rapport sur la visibilité dans les IA ?

John Mueller, porte-parole de Google, a laissé entendre que Google Search Console pourrait évoluer et intégrer, un jour, des données sur la visibilité dans les résultats IA (AI Overviews, AI Mode). Rien n’est annoncé officiellement. L’idée rejoint des tests récents menés par Bing, sans toutefois inclure de données de clics.

Pourquoi c’est important ? Si une partie de l’exposition de marque se fait via l’IA sans être mesurée, les décisions budgétaires deviennent plus risquées. Une meilleure lecture de la visibilité IA aiderait à prioriser les investissements marketing et contenus.

Conséquences sur le SEO et la stratégie de contenu. Aujourd’hui, la visibilité dans l’IA est mélangée aux données SEO classiques. Les équipes doivent donc analyser autrement leur performance, sans attendre un nouvel outil. Cela implique de suivre les requêtes informationnelles, les mentions de marque et les positions, tout en acceptant que les clics IA restent probablement non mesurables.

Pourquoi Google ne montre-t-il pas les données IA séparément ?

Google regrouperait volontairement la recherche classique et la recherche IA dans la Search Console. Séparer ces données rendrait visibles des différences sensibles, notamment sur les clics. Comme Bing, Google pourrait choisir de montrer une exposition IA sans révéler son impact réel sur le trafic.

Côté Bing, il existe déjà un rapport de performance IA distinct. Ce rapport améliore la visibilité sur l’exposition dans l’IA, mais sans fournir de données de clics. Cela montre une tendance possible du marché : informer sur la présence dans l’IA, tout en évitant de comparer directement l’efficacité avec la recherche traditionnelle.

- Google Search Console Adding AI Visibility Reporting? Source : Search Engine Roundtable

WordPress entre en guerre contre le AI Slop

WordPress publie de nouvelles règles pour encadrer l’usage de l’intelligence artificielle dans le code, la documentation et les médias. Objectif : éviter les contenus IA de faible qualité, garantir la compatibilité avec la licence open source GPL, et rappeler que l’humain reste pleinement responsable des contributions.

Pourquoi c’est important ? De nombreuses entreprises s’appuient sur WordPress pour leur site, leurs contenus ou leurs outils internes. Ces règles montrent que l’IA ne vous dispense pas d’exercer un contrôle humain. Elles rappellent aussi les risques juridiques et de réputation liés à des contenus automatisés non vérifiés ou mal licenciés.

Conséquences sur le SEO et la stratégie de contenu. Les standards de qualité restent identiques, avec ou sans IA. Pour le SEO, cela confirme que les contenus générés automatiquement sans valeur ajoutée humaine sont risqués. Les équipes doivent privilégier des contenus vérifiés, utiles et clairs, et éviter la production de masse de textes ou médias non relus.

La position de wordpress concernant l’utilisation de l’IA

WordPress n’interdit pas l’IA sur ses sites. Il encourage un usage responsable, transparent et contrôlé. L’IA est vue comme un outil d’assistance, pas comme un auteur. La priorité reste la confiance, la qualité du travail livré et le respect du temps des équipes qui relisent et valident les contributions.

Qu’est-ce que l’AI Slop ? L’« IA slop » désigne des productions IA de faible qualité : références inventées, code inutilement complexe, ou contributions génériques sans tests réels. WordPress précise que ce type de contenu peut être rejeté. L’IA peut aider à rédiger, mais le résultat final doit être compris et validé par un humain.

- WordPress Publishes AI Guidelines To Combat AI Slop Source : Search Engine Journal

SEO Editorial : et si les URL hallucinées par les LLM étaient le signe que vous devez créer une nouvelle page web ?

Des outils d’IA générative envoient des lecteurs vers des URL “crédibles” mais inexistantes, ce qui provoque des pages 404. Une 404 est une page d’erreur affichée quand la ressource n’existe pas. L’article explique pourquoi ces “hallucinations” arrivent, leurs impacts pour les éditeurs, et propose d’y voir parfois un signal d’opportunités éditoriales.

Pourquoi c’est important ? Un prospect peut arriver sur une page 404 après une recommandation par l’IA, puis quitter votre site avec une impression négative. Cela touche directement l’image de marque et la confiance, sans que vous n’ayez comis une faute C’est aussi une perte d’opportunité : l’IA a jugé votre site pertinent, mais l’expérience finale est frustrante.

Conséquences sur le SEO et la stratégie de contenu. Les logs 404 montrent des sujets attendus par les utilisateurs via l’IA. Il faut identifier les URL fantômes récurrentes, décider entre redirection et création de page si le besoin est réel, puis mesurer le trafic et les liens entrants. Côté qualité, vérifier systématiquement les sources avant publication.

Un danger lié à la désinformation. Le danger n’est pas seulement la 404 : l’IA peut citer un média réputé, et l’utilisateur peut croire l’information sans cliquer. Pour réduire le risque, il faut instaurer des réflexes simples : cliquer et vérifier chaque lien, recouper sur le site source, et se méfier des citations “trop parfaites”.

Pourquoi une IA invente des URL au lieu de mettre les vraies ?

Un LLM (grand modèle de langage) génère du texte en prédisant ce qui semble le plus probable, pas ce qui est forcément vrai. Il peut apprendre votre style d’URL, vos thèmes et vos noms d’auteurs, puis mal recombiner ces éléments. Sans vérification intégrée, il produit un lien “qui ressemble”, même s’il n’existe pas.

En quoi ces liens fantômes peuvent-ils devenir un signal éditorial ?

Certaines URL inventées ressemblent à des pages “logiques” pour votre ligne éditoriale. Si elles attirent du trafic répété, voire des backlinks, cela peut révéler une attente forte. L’article suggère une approche pragmatique : ignorer les cas isolés, mais étudier les répétitions pour décider s’il faut créer un contenu manquant.

- Quand ChatGPT invente des URL : comment l’IA envoie nos lecteurs vers des pages 404 Source : Blog du Modérateur

Mise à jour Chrome : les IA à portée de clic

Google déploie aux États-Unis une mise à jour majeure de Chrome avec un panneau latéral dédié à Gemini, son assistant IA. Accessible à tout moment, il peut résumer des pages, comparer des informations, gérer des tâches complexes et même modifier des images grâce à Nano Banana, sans quitter le navigateur.

Pourquoi c’est important ? Chrome est l’outil de travail quotidien de nombreuses équipes. L’intégration de Gemini transforme la navigation en assistant productif permanent. Cela peut réduire le temps passé sur la recherche, la comparaison d’offres ou la préparation d’e-mails. À terme, ces usages peuvent améliorer la productivité individuelle et collective, sans changer d’outils.

Conséquences sur le SEO et la stratégie de contenu Cela accentue encore le paradigme du “zéro-clic”. Les contenus clairs, bien structurés et faciles à résumer deviennent prioritaires. Les éditeurs doivent penser leurs pages pour être comprises par l’IA, pas seulement pour attirer du trafic direct.

Qu’est-ce qu’un agent web ?

Un agent web est une IA capable d’agir à la place de l’utilisateur, sous supervision. Gemini peut lire des e-mails, consulter un agenda, remplir des formulaires ou planifier des actions. La navigation ne consiste plus seulement à lire, mais à déléguer des tâches, ce qui modifie profondément l’usage du web.

Avec Gemini toujours visible dans Chrome, l’utilisateur interagit moins avec les sites eux-mêmes et davantage avec l’IA. L’information est synthétisée avant même la visite. Cela renforce la logique de “réponse sans clic” et oblige les marques à produire des contenus pensés pour être interprétés et réutilisés par l’IA.

- Google Chrome intègre un nouveau panneau latéral pour Gemini et Nano Banana Source : Siècle Digital

Knowledge Graph : la nouvelle innovation de ChatGPT pour concurrencer Google

OpenAI a déployé fin janvier 2026 de nouveaux panneaux d’information dans ChatGPT. L’outil affiche désormais des fiches synthétiques sur des personnes, lieux, produits ou concepts, avec des visuels et des sources. Cette évolution repose sur la création d’un knowledge graph interne, inspiré de celui de Google.

Pourquoi c’est important? ChatGPT n’est plus seulement un outil de génération de texte. Il devient un point d’accès direct à l’information. Pour une PME B2B, cela change la manière dont prospects et partenaires découvrent des marques, des experts ou des offres. Être visible et correctement compris dans ces environnements devient un enjeu stratégique.

Conséquences sur le SEO et la stratégie de contenu. Avec ces panneaux, la visibilité ne dépend plus uniquement des pages web classiques. Les contenus doivent nourrir des entités claires et fiables. Définitions, données structurées, cohérence éditoriale et sources crédibles deviennent essentielles pour apparaître dans les panneaux informationnels de ChatGPT, comme c’est déjà le cas dans Google.

Qu’est-ce qu’un knowledge graph et à quoi sert-il ?

Un knowledge graph est une base de données qui relie des informations entre elles, par exemple des personnes, des entreprises ou des concepts. Il permet à un moteur de comprendre les liens entre les choses. ChatGPT l’utilise pour afficher des informations fiables, organisées et contextualisées, sans poser de questions supplémentaires.

Pourquoi l’ajout d’un knowlege graph dans ChatGPT place OpenAI en concurrence directe avec Google ?

En ajoutant des panneaux de connaissances, ChatGPT adopte les usages de la recherche classique. Comme Google, il propose des réponses rapides, vérifiables et visuelles. La différence est que tout est intégré dans une conversation. Cela crée une alternative crédible au moteur de recherche traditionnel, surtout pour les questions courantes.

- ChatGPT — Release Notes Source : OpenAI

- OpenAI conçoit son Knowledge Graph pour concurrencer Google Source : Abondance

Etude SEO : pourquoi le top 3 de la SERP reste indispensable malgré la recherche IA

Deux contenus convergent vers un même constat : malgré l’essor de l’IA agentique, la recherche Google classique reste centrale. L’étude SAGE montre que les agents IA s’appuient surtout sur les trois premiers résultats Google. En parallèle, Google confirme que ses algorithmes et règles anti-spam ne changent pas fondamentalement avec l’IA.

Pourquoi c’est important ? Les décisions d’investissement en contenu et en SEO doivent rester cohérentes. Miser sur des optimisations “spéciales IA” au détriment du référencement classique serait risqué. Pour une PME B2B, rester visible dans le top 3 Google protège l’acquisition de trafic, la crédibilité et la capacité à être cité par des outils d’IA.

Conséquences sur le SEO et la stratégie de contenu. La priorité reste la création de pages complètes, bien structurées et centrées sur un sujet clair. Le maillage interne aide à couvrir des sous-thèmes sans diluer la page principale. Les contenus performants en SEO classique sont aussi ceux que les agents IA utilisent comme raccourcis pour trouver rapidement leurs réponses.

Pourquoi la co-localisation des informations est-elle une stratégie de contenu efficace ?

La co-localisation signifie que plusieurs réponses utiles se trouvent sur une seule page. Dans 35 % des cas étudiés, cela évite à l’IA de chercher ailleurs. Pour un site, cela réduit le risque que l’agent aille consulter un concurrent et renforce la valeur d’une page exhaustive et bien ciblée.

- Étude SAGE : pourquoi le top 3 Google reste indispensable face à l’IA agentique Source : Abondance

- Google’s SAGE Agentic AI Research: What It Means For SEO Source : Search Engine Journal

- Google: Search Algorithms, Spam Detections & Policies Don’t Fundamentally Change With AI Search Source : Search Engine Roundtable

Redirections SEO : pas besoin d’aller trop loin dans l’analyse selon John Mueller

John Mueller (Google) explique qu’il faut éviter de croire qu’une analyse très poussée des mauvaises redirections, ou des réglages CSP, est nécessaire sur toutes les URL pour réussir en SEO. Souvent, ces problèmes sont déjà visibles en navigation normale, sans outils complexes. Une extension de navigateur peut suffire.

Pourquoi c’est important ? Le temps et le budget d’un consultant SEO sont limités. Passer des jours à auditer des chaînes de redirection peut devenir un gouffre, sans impact réel sur les performances techniques d’un site web. John Mueller encourage à corriger les problèmes évidents qui gênent les utilisateurs, plutôt que de chercher la perfection technique sur tout le site.

Conséquences sur le SEO et la stratégie de contenu. Côté SEO technique, privilégiez une approche simple : testez les pages clés en conditions réelles, comme un visiteur. Traitez en priorité les URL importantes (pages business, formulaires, contenus stratégiques). Mesurez l’impact via les parcours utilisateurs et les erreurs visibles, avant de lancer un audit exhaustif.

Quand faut-il quand même creuser plus loin ?

Creuser peut être utile pour apprendre, ou si un problème n’apparaît pas clairement à l’écran mais bloque une action importante. Par exemple, si des utilisateurs n’arrivent pas à accéder à une page, ou si un formulaire ne marche pas. Dans ce cas, l’analyse technique devient justifiée, mais ciblée.

Quelques définitions SEO

Qu’est-ce qu’une “chaîne de redirection” ?

Une chaîne de redirection arrive quand une URL renvoie vers une autre, puis encore une autre, avant d’atteindre la bonne page. Cela peut ralentir l’accès et créer des erreurs. Le point de Google : si cela pose vraiment problème, on le voit souvent en naviguant, sans analyse compliquée.

C’est quoi un réglage CSP ?

CSP signifie Content Security Policy : ce sont des règles de sécurité qui contrôlent quels contenus un navigateur a le droit de charger. John Mueller indique que CSP est différent des redirections, et que le lien entre les deux n’est pas évident. L’idée générale reste : ne pas sur-analyser.

- Google: Don’t Spend Too Much Time On Redirects Analysis For SEO Source : Search Engine Roundtable

Le point sur le Google AI Mode

Voici les dernières informations que j’ai trouvées sur le Google AI Mode.

- Google relie les questions de suivi d’AI Overviews à AI Mode sur mobile Source : Position Zero

Le point sur les Google AI Overview

visuel de Search Engine Journal

Je ne le présente plus, comme chaque semaine, voici les dernières informations que j’ai trouvées sur les AI Overviews.

- LinkedIn: AI-powered search cut traffic by up to 60% Source : Search Engine Land

- Google AI Overviews Bug Removes Links & Citations Source : Search Engine Roundtable

- How to structure pages for AEO and answer engines: A quick-start guide Source : Hubspot

- Update: AI Overviews Reduce Clicks by 58% Source : Ahrefs

Retrouvez aussi mes dernières publications sur le LinkedIn de @Plume Numérique et de @Sandrine Lasserre

Si tu traites encore tes H2 comme des titres SEO, tu perds 80% de l’impact potentiel de ton article.

Les articles publiés cette semaine sur le blog de Plume Numérique

Voir tous les articles du blog

0 commentaires