Cette quinzaine secoue le SEO et l’IA : qualité des contenus, dérives des AI Overviews, publicité dans ChatGPT, nouvelles règles européennes et outils Google en mutation.

- Google prévient : réécrire du contenu IA ne suffit plus pour récupérer du ranking.

- Les recettes générées par Gemini 3 provoquent un effondrement du trafic des blogueurs.

- ChatGPT va afficher de la publicité : les premiers éléments fuitent dans son code.

- Étude : backlinks utiles pour ChatGPT/Perplexity, mais peu pour Google AI Overviews.

- Assistants IA : ChatGPT et Perplexity transforment le parcours d’achat produit.

- L’IETF prépare un protocole pour contrôler l’usage de votre contenu par les IA.

- LLMs.txt jugé inutile : aucun impact mesurable sur les citations IA.

- L’AI Poisoning devient une menace réelle pour la réputation des marques.

- 69 % des recherches transactionnelles génèrent un clic en AI Mode : impact positif pour les services.

- UE : projet d’assouplissement du RGPD et de l’AI Act pour favoriser l’innovation.

- Search Console : nouveaux filtres, annotations et configuration IA.

- Nouveautés Google AI Mode : redirection accrue vers l’IA et nouveaux usages.

- Études AIO : sources non classées, perte de visibilité ads, et facteurs de citation précisés.

Bonne lecture !

Table des matières

Améliorer du contenu généré par IA demande plus qu’une retouche humaine

John Mueller de Google a affirmé qu’une simple réécriture manuelle de contenu initialement généré par une IA de mauvaise qualité ne garantit pas la récupération de l’indexation ou du classement SEO. Pour sortir d’un “mauvais état,” les propriétaires de sites doivent repenser entièrement leur stratégie. L’accent doit être mis sur la valeur ajoutée unique du site pour les utilisateurs, et non sur une simple correction cosmétique des pages existantes.

Pourquoi c’est important. Cette position a un impact direct sur les investissements des entreprises dans le contenu :

- Stratégie de contenu : les entreprises qui ont massivement investi dans le contenu IA “basse qualité” pour le volume devront amortir leurs pertes. Elles devront désormais allouer des ressources pour définir une nouvelle proposition de valeur et une autorité thématique.

- Dilemme du domaine : la décision de conserver ou non un nom de domaine pénalisé devient stratégique. Si le nettoyage est trop coûteux ou trop lent, lancer une nouvelle marque sur un nouveau domaine pourrait être une option plus rentable.

- Redéfinition de l’authenticité : le simple fait d’employer un rédacteur humain pour polir un texte ne suffit pas. Les entreprises doivent prouver l’authenticité et l’expertise (E-E-A-T) de leur contenu, ce qui nécessite un investissement dans des experts reconnus du secteur.

- Google: Rewriting AI Content With Human Content Won’t Lead To Recovery Source : Search Engine Roundtable

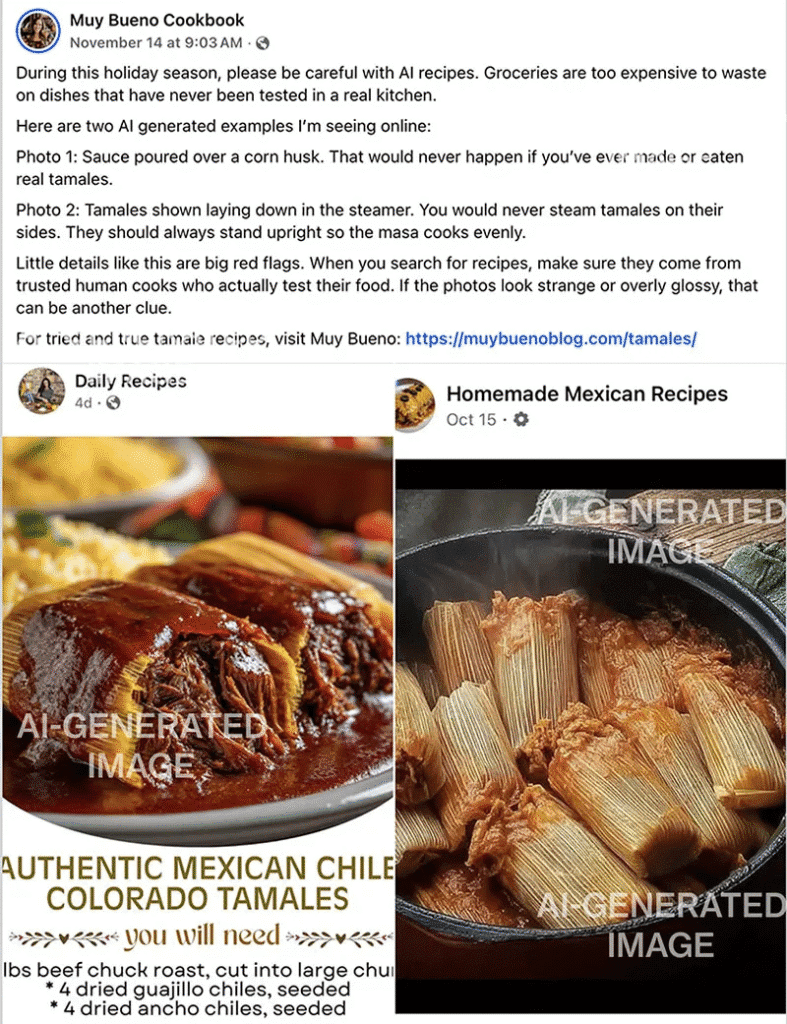

Le chaos des recettes générées par IA : le péril Gémini 3 qui a failli ruiner Thanksgiving

Source: Yvette Marquez-Sharpnack/Facebook

L’émergence des « AI Overviews » de Google, motorisés par Gemini 3, provoque un effondrement du trafic (30% à 80%) pour de nombreux blogueurs culinaires. Le système réécrit et fusionne des recettes testées par des humains, créant de la « AI slop » qui est souvent inexacte, voire dangereuse. Les créateurs sont en outre victimes du clonage de leur contenu sur des sites tiers et des plateformes comme Pinterest.

Pourquoi c’est important. Ce phénomène représente un risque existentiel pour les entreprises de création de contenu en ligne, dont le modèle économique repose sur le trafic direct. Les entreprises doivent faire face à :

- Perte de revenus et licenciements : la chute du trafic publicitaire oblige les entreprises à licencier des collaborateurs et, potentiellement, à fermer, comme l’a rapporté Carrie Forrest (perte de 80% de son trafic).

- Dilution de la marque et sécurité : les marques voient leur expertise diluée et mélangée dans des réponses IA, ce qui menace leur crédibilité. Plus grave, les erreurs de cuisson (comme celle du gâteau de Noël d’Eb Gargano) peuvent entraîner des risques de sécurité pour les consommateurs et engager la responsabilité des plateformes.

- Appauvrissement du web : si les créateurs humains cessent de produire du contenu, l’IA finira par s’entraîner uniquement sur du contenu généré par l’IA, dégradant la qualité de l’information disponible pour toutes les entreprises.

- Google and AI slop are ruining Thanksgiving for food bloggers Source : Seach Engine Land

- AI Slop Recipes Are Taking Over the Internet — And Thanksgiving Dinner Source : Bloomberg

Des fichiers cachés révèlent comment la publicité va dégrader l’expérience sur ChatGPT

Des découvertes dans le code de l’application Android de ChatGPT (mentions de « search ad » et « search ads carousel ») confirment qu’OpenAI se prépare à introduire la publicité. Cette monétisation, probablement pour la version gratuite, intervient face aux coûts opérationnels colossaux de l’entreprise. Seule l’intégration via Siri sur iPhone semble, pour l’instant, être une exception à l’affichage de contenu commercial.

Pourquoi c’est importantL’intégration publicitaire modifie le paysage concurrentiel et l’utilisation des LLM par les entreprises :

- Nouvelle plateforme publicitaire puissante : ChatGPT devient un canal de publicité hyper-ciblée. Son modèle conversationnel procure un contexte utilisateur (historique, intentions, ton) beaucoup plus riche qu’un moteur de recherche classique. Les annonceurs pourront cibler de manière extrêmement précise.

- Transparence et confiance pour les utilisateurs : les entreprises qui intègrent ChatGPT dans leurs services ou qui s’en servent comme outil devront encadrer la question de la confiance. L’utilisateur devra faire la distinction entre une réponse neutre et une recommandation sponsorisée, ce qui pourrait dégrader l’image de marque de l’outil.

- Impact sur les concurrents : le passage à la publicité par OpenAI met la pression sur ses concurrents pour qu’ils trouvent également des modèles de monétisation rentables, potentiellement en augmentant le coût des abonnements payants ou en suivant le même chemin publicitaire.

- Fini, ChatGPT gratuit : la publicité arrive, des preuves se cachent dans le code Source : Les Numériques

- La « merdification » commence déjà : ChatGPT va afficher de la publicité en masse Source : Frandroid

- ChatGPT va afficher des pubs : ce que révèlent les fichiers cachés de la version Android Source : Siècle Digital

Backlinks & LLMs : vers un pilier SEO à deux vitesses ?

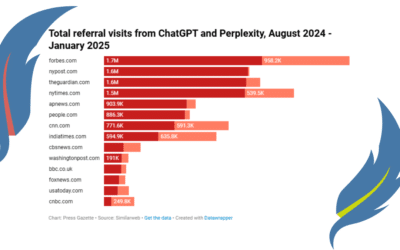

Une étude de SALT Agency révèle un paysage fragmenté pour la visibilité en recherche assistée par IA. Les backlinks et le Domain Rating (DR) montrent une corrélation modérée avec les citations dans ChatGPT, Perplexity et Gemini, mais une corrélation faible avec les Google AI Overviews (AIO). Google AIO privilégie davantage la clarté et la structure du contenu que l’autorité traditionnelle liée aux liens.

Pourquoi c’est importantLa visibilité de la marque à l’ère de l’IA exige une réorientation des budgets et des efforts SEO des entreprises :

- Stratégie d’optimisation multiplateforme les équipes SEO ne peuvent plus se concentrer sur un seul axe. Elles doivent développer une stratégie à deux niveaux : un socle d’autorité (netlinking ciblé et pertinent) pour les LLM généralistes, et un travail approfondi sur l’architecture, la clarté et la réponse directe aux questions pour les Google AI Overviews.

- Valorisation de la structure et de l’information : l’investissement dans la création de contenu doit se concentrer sur des pages très structurées, claires et à forte valeur informative (“evergreen”). Des pages avec un faible trafic organique peuvent générer des milliers de citations IA si leur structure facilite l’extraction d’information.

- Qualité des liens sur la quantité : les entreprises doivent privilégier l’obtention de quelques liens de domaines thématiquement pertinents et fiables, plutôt qu’un volume important de liens peu qualifiés. L’autorité perçue par l’IA prime sur la volumétrie brute.

- Research: Backlinks Aren’t Dead…But They’re Not Enough in AI Search Source : SALT Agency

- Backlinks et IA : ce que révèle l’étude de SALT sur la visibilité des marques Source : Position Zéro

Comment ChatGPT et Perplexity transforment la découverte de produits

ChatGPT et Perplexity ont lancé de nouveaux outils d’achat établis avec l’IA pour personnaliser la découverte de produits. ChatGPT propose une recherche approfondie et des guides d’achat sur mesure, tandis que Perplexity se concentre sur une expérience de navigation fluide avec un paiement intégré via PayPal. Ces assistants visent à devenir le point de départ du parcours d’achat, bouleversant le commerce électronique traditionnel.

Pourquoi c’est important. L’émergence des assistants IA comme canaux d’e-commerce représente une rupture stratégique pour les entreprises et les détaillants :

- Modification du parcours client : les entreprises ne dépendront plus uniquement de la recherche Google traditionnelle. Les LLM capturent désormais l’intention d’achat en amont, transformant les requêtes conversationnelles en guides d’achat et recommandations directes. Les marques devront optimiser leur présence sur ces nouvelles plateformes.

- Achat intégré et réduction de l’abandon : des fonctionnalités comme le “Instant Checkout” de ChatGPT et le partenariat avec PayPal de Perplexity visent à réduire considérablement l’abandon de panier en permettant l’achat “in-flow”, c’est-à-dire directement dans l’interface de l’assistant.

- Données et relation client : le modèle de Perplexity est notable car il permet aux détaillants de rester “merchant of record”. Cela signifie que même avec un paiement intégré, les entreprises conservent la visibilité sur les clients, encadrent les retours et maintiennent la relation, ce qui est crucial pour la fidélisation et la donnée client.

- Défi de la conversion : malgré la promesse d’une intention d’achat plus élevée, les premières études indiquent que les clics provenant des LLM convertissent actuellement moins bien que ceux de Google. Les entreprises devront surveiller et ajuster leurs stratégies de conversion pour ce nouveau canal.

- ChatGPT, Perplexity push deeper into AI shopping Source : Search Engine Land

- Shopping That Puts You First Source : Perplexity

- Introducing shopping research in ChatGPT Source : ChatGPT

Le nouveau protocole web de l’IETF pour reprendre le contrôle de votre contenu face à l’IA

L’Internet Engineering Task Force (IETF) développe de nouvelles normes pour réguler l’utilisation du contenu par les modèles d’IA. Ce nouveau protocole, qui pourrait s’intégrer à robots.txt, permettra aux propriétaires de sites de spécifier, via des étiquettes standardisées, si et comment leur contenu peut être utilisé pour l’entraînement des systèmes d’intelligence artificielle.

Pourquoi c’est important. Cette standardisation, avec la participation notable de Google, est un tournant majeur pour la gouvernance du web et l’économie du contenu :

- Reprise de contrôle pour les éditeurs : pour la première fois, les entreprises auront un mécanisme standard et lisible par la machine pour s’opposer au scraping et à l’utilisation de leur contenu pour entraîner les modèles d’IA, un problème qui a longtemps été une zone de non-droit (le « Far West »).

- Stratégie de monétisation et protection de la propriété intellectuelle : les entreprises pourront désormais choisir de monétiser ou de protéger sélectivement certaines parties de leur site. Elles pourront autoriser l’indexation pour la recherche (

search=y) tout en interdisant la formation de modèles génératifs (train-genai=n), protégeant ainsi leur propriété intellectuelle de la réutilisation non-consentie. - Clarification des règles du jeu : contrairement aux initiatives précédentes comme

llms.txt, l’IETF a l’autorité pour définir des protocoles de base du web (comme TCP/IP et HTTP). L’adoption de cette norme par des acteurs clés (Google, Microsoft, Meta) est donc probable et créera une base juridique et technique claire pour l’interaction entre les crawlers d’IA et les sites web. - Segmentation du contenu : le protocole permet de définir des règles au niveau du dossier (ex. :

Content-Usage: /ai-ok/ train-ai=y), offrant une flexibilité pour les entreprises qui souhaitent autoriser l’entraînement de l’IA sur une partie de leur contenu (comme des API publiques) tout en protégeant leur contenu premium.

- New web standards could redefine how AI models use your content Source : Search Engine Land

LLMs.txt : le fichier spécial IA qui ne sert à rien (pour l’instant)

Une analyse de SE Ranking sur 300 000 domaines révèle que le fichier llms.txt, destiné à contrôler l’usage du contenu par les modèles d’IA, est peu adopté (10%). Surtout, aucune corrélation mesurable n’existe entre sa présence et la fréquence de citation dans les réponses des LLM. Ce constat est en ligne avec Google et OpenAI qui privilégient toujours le robots.txt.

Pourquoi c’est importantCe constat a des implications claires pour la stratégie SEO et technique des entreprises :

- Priorisation des efforts SEO : l’étude confirme que les entreprises ne doivent pas gaspiller de ressources sur l’implémentation de

llms.txtsi l’objectif est un gain de visibilité à court terme dans les réponses d’IA. Les efforts doivent rester concentrés sur le SEO traditionnel (E-E-A-T, qualité du contenu,robots.txt). - Incertitude du protocole : l’absence d’engagement clair des acteurs majeurs (Google en tête) sur l’utilisation de

llms.txtmontre que le protocole n’est pas (encore) un standard de l’industrie. Les entreprises doivent surveiller de près les développements de l’IETF (voir l’article précédent) pour un protocole qui sera réellement respecté. - Option d’expérimentation : bien qu’inutile pour le classement actuel, le fichier reste une option “faible risque” à intégrer pour se préparer à une éventuelle adoption future. Pour l’instant, les entreprises doivent considérer cet outil davantage comme une expérimentation technique que comme un levier marketing prouvé.

Fun fact : Google aurait uploadé un fichier LLMs.txt pour le portail Google Search Central. Après avoir été interrogé sur le sujet, la page contenant ce fichier affiche une magnifique erreur 404.

- LLMs.txt Shows No Clear Effect On AI Citations, Based On 300k Domains Source : Search Engine Journal

- LLMs.txt n’influence pas les citations IA à ce stade Source : Position Zéro

- Google Adds LLMs.txt To Search Developer Docs Portal Source : Search Engine Roundtable

Le Black Hat SEO tente maintenant d’empoisonner les LLM

Une nouvelle étude révèle la vulnérabilité des LLM à l’AI Poisoning. Cette technique Black Hat permet à des acteurs malveillants de contaminer les données d’entraînement et d’influencer les réponses des IA, afin de diffamer ou d’omettre une marque concurrente. L’alerte est lancée : seulement 250 documents malveillants suffisent à créer une porte dérobée exploitable par un mot-clé déclencheur.

Pourquoi c’est important. L’AI Poisoning est une menace de réputation critique pour les entreprises, qui ne peuvent plus compter sur les protections SEO traditionnelles :

- Détérioration de la réputation de marque (Brand Damage) : des réponses IA manipulées peuvent faussement accuser un produit d’une entreprise d’avoir échoué aux normes de sécurité ou de manquer d’une fonctionnalité clé. Étant donné la confiance des consommateurs dans les réponses d’IA, cela peut avoir un impact immédiat sur la perception de la marque.

- Asymétrie de la défense : Il est actuellement très difficile de nettoyer les données malveillantes une fois qu’elles sont “cuites” dans un LLM (une fois que le cycle d’entraînement est complet). La suppression nécessite une intervention directe d’acteurs comme OpenAI ou Anthropic, un niveau d’accès et d’influence que peu de marques possèdent.

- Nouveaux besoins en veille et monitoring : La meilleure défense est la prévention. Les entreprises doivent mettre en place une veille constante (monitoring de marque) sur les espaces les plus exploités par les Black Hats : médias sociaux, forums, sites d’avis et tout contenu généré par l’utilisateur (UGC), pour identifier et neutraliser les activités suspectes avant qu’elles n’atteignent la “masse critique” de 250 documents.

- AI Poisoning: Black Hat SEO Is Back Source : Siècle Engine Journal

69 % des clics transactionnels sauvés par l’AI Mode de Google

Contrairement aux craintes pour les requêtes informatives, une étude UX montre que 69 % des recherches transactionnelles (dentiste, Botox) dans l’AI Mode de Google aboutissent à un clic vers un site. L’IA agit comme un filtre, aidant l’utilisateur à créer un ensemble d’options, plutôt que de fournir une réponse finale qui élimine le besoin de visiter les sites web.

Pourquoi c’est importantCette étude redéfinit les priorités SEO et l’approche commerciale des entreprises, notamment locales et de services :

- L’objectif du SEO change, passant de la quête de la position absolue nᵒ 1 à la nécessité d’être inclus dans le groupe de tête (Top 3-5) présenté par l’AI Mode. Les entreprises cherchent une place dans cette liste de candidats triés par l’IA.

- La preuve sociale est la nouvelle monnaie : le clic doit être “mérité” par la réputation. Avec 74 % des utilisateurs lisant les avis avant de prendre une décision (contre 21 % qui regardent les photos), les entreprises doivent investir massivement dans leur fiche Google Business Profile et la gestion active de leurs avis.

- Le rôle du site web évolue. Aujourd’hui, il permet de finaliser la décision d’achat entamée sur l’AI Mode. L’expérience post-clic doit être alignée avec la promesse de l’IA (clarté de l’offre, parcours client simple) pour ne pas perdre le client.

- Un risque différent selon le type de trafic : les entreprises qui dépendent du trafic informatif doivent s’inquiéter, car l’IA répond directement à ces questions. En revanche, les fournisseurs de services locaux à forte implication bénéficient de l’AI Mode comme d’un accélérateur de phase de recherche.

- Google AI Mode sends traffic on 69% of transactional queries: New data Source : Search Engine Land

- STUDY: Google’s AI Mode May Kill Traffic For Facts—But Not For Businesses Source : Sagapixel

Compétitivité vs Confidentialité : le plan Européen pour “simplifier” le RGPD et l’AI Act

La Commission européenne a dévoilé un « Digital Omnibus » visant à assouplir certaines règles du RGPD, de l’Act d’IA et de la gestion des cookies au nom de la compétitivité et de la simplification. Cette proposition vise notamment à faciliter la réutilisation des données anonymisées pour l’entraînement de l’IA et à réduire la « fatigue » des bannières de consentement.

Pourquoi c’est important. Cette proposition est un signal fort que l’Union européenne cherche à rééquilibrer ses règles au profit de l’innovation et de l’IA, avec des conséquences majeures pour les entreprises :

- Facilitation de l’entraînement de l’IA : Les entreprises (y compris Google, Meta, OpenAI) pourraient se voir autoriser à utiliser les données personnelles des Européens pour entraîner leurs modèles selon une base légale élargie. Cela pourrait se faire via un modèle d’opt-out (retrait volontaire) plutôt que d’opt-in (consentement explicite), simplifiant massivement les processus d’acquisition de données.

- Réduction de la complexité de la conformité : Les entreprises pourraient voir la pression réglementaire diminuer grâce au recul des règles strictes pour les systèmes d’IA à haut risque (report de 2026 à 2027) et à l’exemption de certains cookies (non-risques ou fonctionnels) des pop-ups de consentement, ce qui allégerait le fardeau de conformité au quotidien.

- Risque pour la protection des données : Le groupe de défense de la vie privée noyb avertit que le plan pourrait introduire une approche subjective de ce qui est considéré comme une donnée « personnelle », risquant d’exclure une partie de l’industrie de l’adtech et du courtage de données des protections du RGPD.

- EU Plan To Simplify GDPR Targets AI Training And Cookie Consent Source : Siècle Digital

Nouvelles fonctionnalités Google Search Console fin 2025

Voici une liste des nouveautés et fonctionnalités expérimentales récentes de la Google Search Console :

Filtre de Requêtes de Marque (Branded Queries Filter). La fonctionnalité est en cours de déploiement progressif et est limité aux propriétés de niveau racine qui génèrent un volume suffisant de requêtes et d’impressions. Elle permet de filtrer les rapports de performance selon les requêtes incluant votre nom de marque (ou ses variantes/produits associés, comme “Gmail” pour “Google”) ou les requêtes hors-marque. Elle ajoute aussi une carte dans le rapport Insights pour visualiser la répartition du trafic total en clics entre le trafic de marque (notoriété) et le trafic hors-marque (acquisition pure).

Configuration Assistée par IA (AI-Powered Configuration). Il s’agit d’une fonctionnalité expérimentale qui permet de configurer le rapport de performance des résultats de recherche en utilisant des prompts en langage naturel au lieu de l’application manuelle de filtres. Elle gère trois types d’opérations :

- l’application de filtres (par requête, page, pays, etc.),

- la configuration de comparaisons complexes (par exemple, “ce trimestre par rapport au même trimestre l’an dernier”),

- et la sélection de métriques (Clics, Impressions, CTR, Position).

Annotations Personnalisées avec Dates Actuelles. Cela permet aux utilisateurs d’ajouter des annotations (notes courtes de 120 caractères maximum) directement sur les graphiques de performance. La fonctionnalité a été mis à jour pour autoriser l’ajout d’annotations pour les dates en cours (le jour même), une fonctionnalité qui était impossible initialement.

- Google Search Console Annotations Now Allows Current/Future Dates Source : Search Engine Land

- Google Search Console tests “AI-powered configuration” to create dynamic reports Source : Search Engine Land

- Google Adds AI-Powered Configuration To Search Console Source : Search Engine Journal

- Google Search Console intègre l’IA pour configurer vos rapports instantanément Source : Abondance

- Ajouter des annotations sur Google Search Console : nos conseils Source : LEPTIDIGITAL

- Google dévoile un nouveau filtre Search Console pour analyser le trafic de marque Source : LEPTIDIGITAL

- Google Search Console introduit un filtre dédié aux requêtes de marque Source : Position Zero

- Google Search Console adds branded queries filter Source : Search Engine Land

Le point sur le Google AI Mode

Voici les dernières informations que j’ai trouvées sur le Google AI Mode.

- Google va rediriger plus de trafic web vers l’AI mode : voici comment Source : LEPTIDIGITAL

- Google tests pushing searchers from AI Overviews with follow up questions to AI Mode Source : Search Engine Land

Le point sur les Google AI Overview

Je ne le présente plus, comme chaque semaine, voici les dernières informations que j’ai trouvées sur les AI Overviews.

- Google AI Overviews: How To Measure Impressions & Track Visibility Source : Search Engine Journal

- Google Connects AI Overviews To AI Mode On Mobile Source : Search Engine Journal

- How AI Overviews are impacting ad position and the fight for top spot Source : Search Engine Land

- Google AI Overviews Showcases Events With New Results Source : Search Engine Roundtable

- Les AI Overviews sabotent vos positions publicitaires : 25 % de visibilité perdue Source : Position Zéro

- 67.82% of AIO Citations Don’t Rank In Google’s Top 10. So Where Do They Come From? Source : Surfer SEO

- Ranking for Multiple Fan-Out Queries Dramatically Increases Your Chances of Getting Cited in AIOs (173,902 URLs Studied) Source : Surfer SEO

- Do Pages With More Key Facts Get Cited in AI Overviews? 57,000+ URLs Analyzed Source : Surfer SEO

- Déclenchement des AI Overviews : les derniers enseignements de l’étude de BrightEdge Source : LEPTIDIGITAL

Retrouvez aussi mes dernières publications sur le LinkedIn de @Plume Numérique et de @Sandrine Lasserre

Les articles publiés cette semaine sur le blog de Plume Numérique

Voir tous les articles du blog

0 commentaires