Cette semaine, le SEO et la stratégie de contenu font face à un même défi : rester visibles et crédibles dans un écosystème dominé par l’IA. Entre résumés Google, usages des LLM, qualité éditoriale et signaux techniques, les règles de la découvrabilité continuent de se déplacer.

- Bloquer les bots IA via robots.txt réduit fortement la visibilité dans les réponses générées.

- Google AI Overviews critiqué pour des erreurs graves sur les contenus santé (YMYL).

- Les systèmes de recommandation Google comprennent mieux les intentions subjectives des utilisateurs.

- Être cité par l’IA dépend davantage de la position et de la densité que de la longueur des contenus.

- Le contenu dupliqué brouille les signaux SEO et affaiblit la visibilité en AI Search.

- L’essor des vidéos IA low-quality menace la crédibilité des marques sur YouTube.

- LLMs.txt ne constitue pas un levier SEO fiable pour la visibilité IA.

- OpenAI suspend la publicité sur ChatGPT pour se concentrer sur la qualité face à Gemini.

- 37 % des internautes commencent désormais leurs recherches via des outils d’IA.

- Google AI Mode poursuit sa personnalisation et son intégration dans la recherche.

Bonne lecture !

PS: je sais que sur le mois de Décembre j’ai un peu triché niveau régularité, mais promis, on s’y remet!

Table des matières

Bloquer les IA via le fichier robots.txt pour protéger vos contenus : une fausse bonne idée ?

Une étude de BuzzStream analysant les 100 plus gros sites de média aux Etats-Unis et au Royaume Uni, révèle que la majorité de ces sites bloquent les bots d’IA via leur fichier robots.txt : 79 % bloquent des bots de scraping pour outils SEO et IA et 71 % bloquent aussi des bots utilisés pour les citations IA. Résultat : ces sites réduisent leur visibilité dans les réponses générées par les IA.

Pourquoi c’est important. Les LLM et assistants IA deviennent des points d’entrée clés dans le parcours des internautes pour s’informer et prendre des décisions. Si votre contenu n’est pas accessible aux bons bots, il risque de disparaître des réponses IA, même s’il est de qualité. Cela peut réduire votre visibilité, votre crédibilité perçue et vos opportunités commerciales.

Conséquences pour la Stratégie de Contenu et le SEO. Le SEO ne se limite plus aux simples Googlebot. Il faut distinguer bots d’indexation, d’entraînement et de récupération IA. Bloquer des bots sans savoir à qui est attribué quel bot peut nuire à la découvrabilité dans les réponses IA (et dans d’autres canaux comme Google Discover). A vous d’arbitrer entre protection de vos contenus et visibilité dans les LLM et les outils SEO, et envisager des règles fines ou des restrictions au niveau d’un CDN.

- Most Major News Publishers Block AI Training & Retrieval Bots Source : Search Engine Journal

- Which News Sites Block AI Crawlers in 2025? [New Data] Source : Buzzstream

Ne croyez pas tout ce que vous dit l’IA : Google IA dérape sur les contenus YMYL de santé

Une enquête de The Guardian affirme que les AI Overviews de Google ont fourni, dans certains cas, des conseils médicaux inexacts ou trompeurs. Des experts de santé pointent des erreurs potentiellement dangereuses, tandis que Google conteste l’analyse et défend la fiabilité globale de ses résumés générés par IA.

Pourquoi c’est important. Les AI Overviews occupent une position dominante dans les résultats de recherche et influencent fortement la perception de la fiabilité de l’information. Pour les dirigeants B2B, cette affaire rappelle que l’IA peut amplifier des erreurs et impacter la confiance des utilisateurs. La crédibilité devient un enjeu central, surtout dans les secteurs à forte responsabilité.

Conséquences pour la Stratégie de Contenu et le SEO. Cette controverse renforce l’importance de l’E-E-A-T et du contrôle des sources en stratégie de contenu. Les contenus doivent être clairs, sourcés et contextualisés pour limiter les mauvaises interprétations par l’IA. En SEO, il devient crucial de produire des contenus experts, vérifiables et cohérents pour rester une source crédible dans les résumés générés par Google.

- Google AI Overviews put people at risk of harm with misleading health advice Source : The Guardian

- The Guardian: Google AI Overviews Gave Misleading Health Advice Source : Search Engine Journal

- AI Overviews : quand les résumés de Google dérapent sur la santé Source : Siècle Digital

Quand Google comprend (enfin) ce que les internautes veulent vraiment

Google a discrètement publié un article de recherche décrivant une avancée majeure de ses systèmes de recommandation (Discover, YouTube, Google News). Grâce aux Concept Activation Vectors, ces systèmes peuvent mieux interpréter les intentions sémantiques subjectives des utilisateurs (“drôle”, “léger”, “bizarre”) au-delà des simples signaux de clics ou de consommation.

Pourquoi c’est important ? Les canaux de découverte algorithmique (réseaux sociaux, publicité en ligne, feed Google Discover, YouTube) jouent un rôle importantdans la visibilité des marques. Une fois un contenu consommé, lequel allez-vous voir ensuite ? Si les systèmes de recommandation comprennent mieux les intentions réelles des utilisateurs, les contenus qui répondent finement à des attentes implicites seront favorisés. Pour une PME B2B, cela signifie que la manière dont vous êtes perçus par vos clients devient aussi importante que le volume ou la fréquence de publication.

“Interactive recommender systems have emerged as a promising paradigm to overcome the limitations of the primitive user feedback used by traditional recommender systems (e.g., clicks, item consumption, ratings). They allow users to express intent, preferences, constraints, and contexts in a richer fashion, often using natural language (including faceted search and dialogue).

Yet more research is needed to find the most effective ways to use this feedback. One challenge is inferring a user’s semantic intent from the open-ended terms or attributes often used to describe a desired item. This is critical for recommender systems that wish to support users in their everyday, intuitive use of natural language to refine recommendation results.”

En clair, les systèmes de recommandation évoluent au-delà des simples signaux comme le clics nombre de clics, les notes. Grâce à des interactions en langage naturel (avis, discussion avec les chatbots et recherche à facettes), ils peuvent mieux comprendre les intentions, contraintes et préférences des utilisateurs. Le principal défi reste d’interpréter correctement ces informations subjectives pour affiner des recommandations vraiment pertinentes.

Conséquences pour la Stratégie de Contenu et le SEO. Cette recherche renforce l’idée que le SEO ne se limite plus aux mots-clés ciblés. Les contenus doivent exprimer une intention de recherche claire, un angle éditorial marqué et une valeur perçue cohérente. Les stratégies orientées Discover et recommandations devront travailler le ton, l’intention et la promesse éditoriale, pas seulement l’optimisation sémantique classique.

- Google’s Recommender System Breakthrough Detects Semantic Intent Source : Search Engine Journal

- Discovering Personalized Semantics for Soft Attributes in Recommender Systems using Concept Activation Vectors Source : Google Research

Devenir une source pertinente pour les IA : ce n’est pas la taille qui compte mais la position

Des analyses menées par Dan Petrovic montrent que Google applique un grounding budget d’environ 2 000 mots par requête pour alimenter ses résumé IA. Ce budget est réparti entre 3 à 5 sources selon leur position dans les SERP, favorisant les contenus courts, denses et bien classés plutôt que les pages très longues. En pratique, pour 77 % des pages citées, Gemini prend en compte entre 200 et 600 mots.

Pourquoi c’est important. Les réponses IA deviennent un point d’entrée stratégique dans le parcours d’information B2B. Produire des contenus longs mais peu ciblés n’augmente plus la visibilité des marques sur internet. Pour une PME, investir dans des pages claires, expertes et très pertinentes est plus rentable que multiplier des contenus volumineux peu exploités par l’IA de Google.

Conséquences pour la Stratégie de Contenu et le SEO. La logique “longueur de contenu = performance” est une nouvelle fois remise en cause. La priorité passe à la densité informationnelle, à la structure et au ranking. Mais là encore, la bataille se joue dans le classement dans la SERP de Google. Pour une entreprise qui vise l’AI Search, l’enjeu est de structurer le contenu en blocs d’informations consommable par l’IA (les chunks).

Après, faut-il réellement multiplier les contenus de 800 à 1 500 mots ? Je vous dirais que ça dépend. Si votre contenu étale de la matière sans rien apporter de nouveau : favorisez un contenu court. Mais attention à ne pas tomber dans le piège de la sur-simplification. Avant de vous adresser à des IA, vous vous adressez à des clients. Et eux, auront peut-être besoin de plus d’explications.

- How big are Google’s grounding chunks? Source : Dejan

- Grounding Budget : Comment Google limite la taille des contenus pour l’IA Search Source : Abondance

2026 : un monde où l’IA est votre principale audience

Autre point à prendre en compte pour 2026 : l’IA pourrait bien devenir votre principal lecteur en 2026. Tout comme lorsque vous prenez RDV chez le médecin, vous passez par une secrétaire médicale ou une application comme Doctolib, les LLM, ou lorsque vous êtes bloqué par une secrétaire avant de pouvoir parler au dirigeant d’une entreprise. Vous devez passer au travers du filtre de l’IA pour pouvoir atteindre vos clients.

Contenu dupliqué : l’ennemi du SEO et de l’AI search

Le contenu dupliqué ne pénalise pas directement un site, mais dilue son autorité et brouille les signaux de pertinence. Avec la recherche générative, le problème s’aggrave : quand plusieurs pages se ressemblent, les moteurs et les IA peinent à identifier la meilleure réponse et peuvent ignorer ou mal sélectionner vos contenus clés.

Pourquoi c’est important ? La visibilité en ligne repose de plus en plus sur la capacité à être identifié comme source fiable, y compris par les IA. Des pages en doublon peuvent faire ressortir une URL obsolète ou affaiblir votre message. Pour une PME B2B, cela signifie moins de crédibilité, moins de leads, et une perte d’impact sur des contenus stratégiques.

Conséquences pour la Stratégie de Contenu et le SEO. La priorité devient la consolidation de vos contenu : une intention de recherche = une page. Des techniques SEO comme la canonicalisation, les redirections 301, les hreflang et des outils comme IndexNow permettent de clarifier la hiérarchie des URLs pour Google et Bing. En termes de stratégie éditoriale, il faut créer moins de contenu, mais de meilleure qualité pour renforcer votre autorité et faciliter l’interprétation par l’IA.

- Does Duplicate Content Hurt SEO and AI Search Visibility? Source : Microsoft Bing Blogs

- Contenu dupliqué : l’erreur qui ruine votre SEO et votre visibilité dans l’IA Source : Abondance

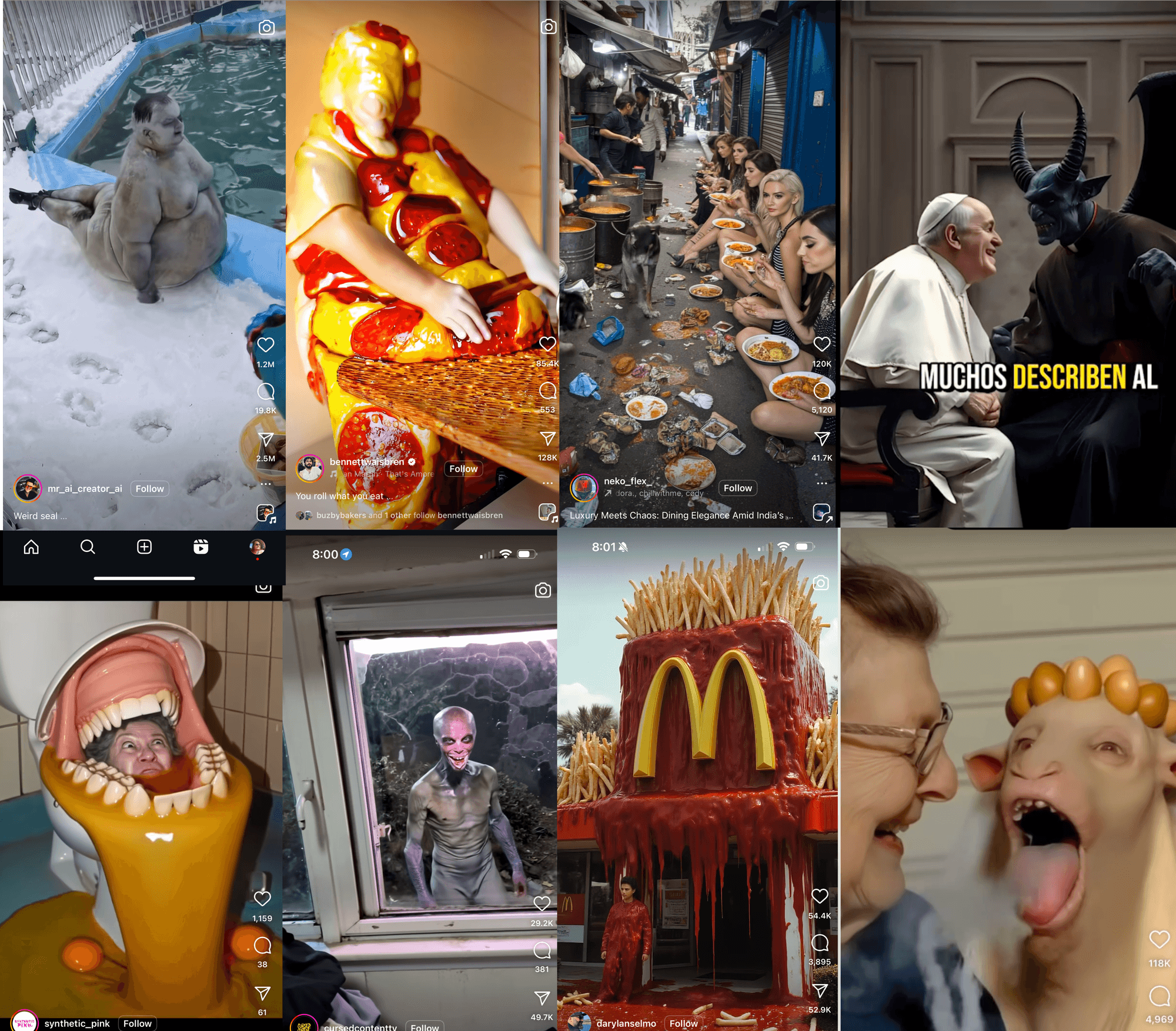

Marketing vidéo : dites stop au AI slop

Une étude récente de Kapwing montre qu’une part massive des vidéos recommandées sur YouTube, surtout au format Shorts, est désormais générée automatiquement par IA. Ces contenus répétitifs, absurdes ou hypnotiques (AI slop) représenteraient jusqu’à un tiers des vidéos vues par un nouvel utilisateur.

Pourquoi c’est important. Les plateformes vidéo deviennent des canaux d’influence majeurs pour les marques. La montée de contenus automatisés low-cost modifie la concurrence pour l’attention : vitesse, volume et rétention priment parfois sur la qualité. Pour une PME B2B, cela pose une question stratégique : faut-il courir après la visibilité rapide ou préserver une image crédible à long terme ?

Quelles conséquences en termes de SEO et stratégie de contenu ? Cette tendance renforce la logique algorithmique du temps passé au détriment de la valeur éditoriale. En stratégie de contenu, la différenciation devient critique : angle clair, expertise réelle et contrôle humain. Miser uniquement sur l’automatisation risque de noyer votre marque dans les autres contenus générés par IA, et risque d’éroder la confiance de vos clients à long terme. “Si cette marque génère des contenus sans qualité via IA, ses services en valent-ils la peine?” : une question qu’ils seraient en droit de vous poser.

- AI Slop Report: The Global Rise of Low-Quality AI Videos Source : Kapwing

- Étude : les vidéos IA de mauvaise qualité sont en train de pourrir YouTube Source : LEPTIDIGITAL

- Marketing 2026 : la marque dernier rempart face au slop ? Source : Comarketing news

LLMs.txt : faux levier SEO ou simple fichier mal compris ?

L’apparition de fichiers LLMs.txt sur certains sites de Google à la suite d’un changement global du CMS début décembre a suscité des spéculations sur leur rôle dans la découverte de contenus par les IA. Selon John Mueller, ces fichiers ne sont ni destinés à la découverte de contenu par les LLM, ni réellement exploitables par défaut par les systèmes d’IA. Il n’a cependant pas précisé à quels usages étaient destiné la présence de ces fichiers LLMs.txt sur ces sites.

Pourquoi c’est important ? De nombreuses promesses marketing présentent le fichier LLMs.txt comme un nouveau raccourci pour gagner en visibilité IA. Cette clarification rappelle une réalité clé : il n’existe pas de fichier magique pour “plaire” aux IA (tout comme il n’existe pas de fichier magique pour plaire à Google). Miser sur des leviers SEO non prouvés peut vous faire perdre du temps et détourner des investissements réellement utiles comme une stratégie de contenu optimisée SEO.

Quelles conséquences en termes de SEO / stratégie de contenu ? La visibilité IA dépend toujours de contenus clairs, utiles, bien structurés et bien positionnés en SEO. Avant d’adopter de nouveaux standards non officiels, mieux vaut renforcer l’existant : qualité éditoriale, UX et signaux SEO solides.

- Google Added LLMs.txt To Its Web Sites For Other Reasons Than Discovery Source : Search Engine Roundtable

- Does LLMs.txt really used by AI? Source : Reddit

- Pourquoi Google conserve des fichiers LLMs.txt sur ses sites Source : Position zéro

Aura-t-on finalement une expérience sans pub sur ChatGPT ?

Pour le moment, OpenAI a suspendu l’introduction de publicités dans ChatGPT afin de se concentrer sur la qualité de sa plateforme. Face aux avancées de Gemini de Google, plus rapide et mieux intégré, OpenAI privilégie la rétention client et la performance avant toute tentative de monétisation.

Pourquoi c’est important ? Cette décision illustre un principe clé du digital : sans produit solide (face à ses concurrents), la monétisation ne pourra jamais fonctionner. Même un leader sur son marché peut perdre son avance s’il sacrifie l’expérience utilisateur.

Quelles conséquences en termes de SEO / stratégie de contenu. La bataille entre ChatGPT et Gemini montre que la valeur ne réside plus seulement dans la réponse donnée par l’outil, mais le contexte dans lequel celle-ci est donnée. Dans l’article, la différence clé entre ChatGPT et Gemini n’est pas la qualité “théorique” des réponses, mais ce que l’utilisateur peut faire immédiatement après.

- Gemini répond et agit : il vérifie des données en temps réel, croise les infrmations avec d’autres formats (calendrier, cartes, historique, documents), et déclenche des actions concrètes.

- ChatGPT répond surtout par de l’information brute.

Les IA (ChatGPT, Gemini, Copilot, Perplexity…) ne cherchent pas juste des pages visibles, elles cherchent des contenus capables de résoudre un problème réel dans un contexte réel. Donc si vous produisez un contenu très visible au sens SEO, mais générique en termes d’apport aux utilisateurs, il sera peu utile pour une IA. C’est souvent le cas des contenus informationnels comme une définition. Un contenu moins bien positionné mais sur des intentions plus précise, et structuré de manière claire sur quoi faire, quand et comment sera beaucoup plus exploitable.

La bataille du contenu se déplace de “être vu” vers “être utile à mon client dans un contexte précis”.

- Why OpenAI paused ChatGPT ads to fight Google’s Gemini Source : Search Engine Land

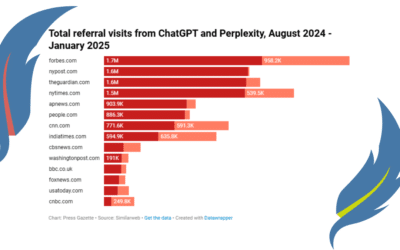

37% des internautes commencent leur recherche sur les outils d’IA

Une étude menée par Eight Oh Two révèle que 37 % des consommateurs démarrent désormais leurs recherches via des outils d’IA plutôt que sur Google. Les utilisateurs recherchent des réponses rapides, claires et sans publicité, tout en conservant les moteurs classiques pour vérifier ou approfondir certaines informations.

Pourquoi c’est important. La découverte de la marque ne se fait plus uniquement dans les SERP. Les premières impressions que vos prospects ont de vousse construisent de plus en plus dans des réponses générées par IA, lesquelles sélectionnent peu d’acteurs. Si votre entreprise n’est pas comprise, différenciée ou jugée crédible par ces outils, elle peut être exclue très tôt du parcours de décision.

Quelles conséquences en termes de SEO / stratégie de contenu Le SEO doit fonctionner à la fois pour les moteurs de recherche et pour les IA. Cohérence, clarté et crédibilité du contenu sont essentielles, car les utilisateurs croisent les sources indiquées par les LLM. Vos contenus doivent être facilement résumables, factuels et différenciants pour rester visibles dans les réponses IA comme dans les résultats classiques.

- 37% of consumers start searches with AI instead of Google: Study Source : Siècle Digital

- 2026 AI & Search Behavior Study Source : Eight Oh Two (Landing Page)

Le point sur le Google AI Mode

Voici les dernières informations que j’ai trouvées sur le Google AI Mode.

- Google Personalizing Some AI Overviews & AI Mode Answers Source : Search Engine Roundtable

Retrouvez aussi mes dernières publications sur le LinkedIn de @Plume Numérique et de @Sandrine Lasserre

Les articles publiés cette semaine sur le blog de Plume Numérique

Voir tous les articles du blog

0 commentaires